# Kubernetes[TOC]

VPC 私有网络,不同 VPC 之间相互隔离

k8s 大规模容器编排系统

master/node 模式

# k8s 特性

服务发现和负载均衡 存储编排 自动部署和回滚 自动完成装箱计算 自我修复 密钥与配置管理

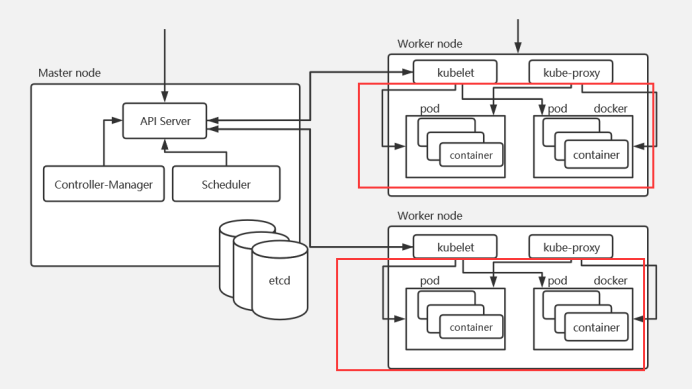

# 架构主节点 (master) + 工作节点 (worker)

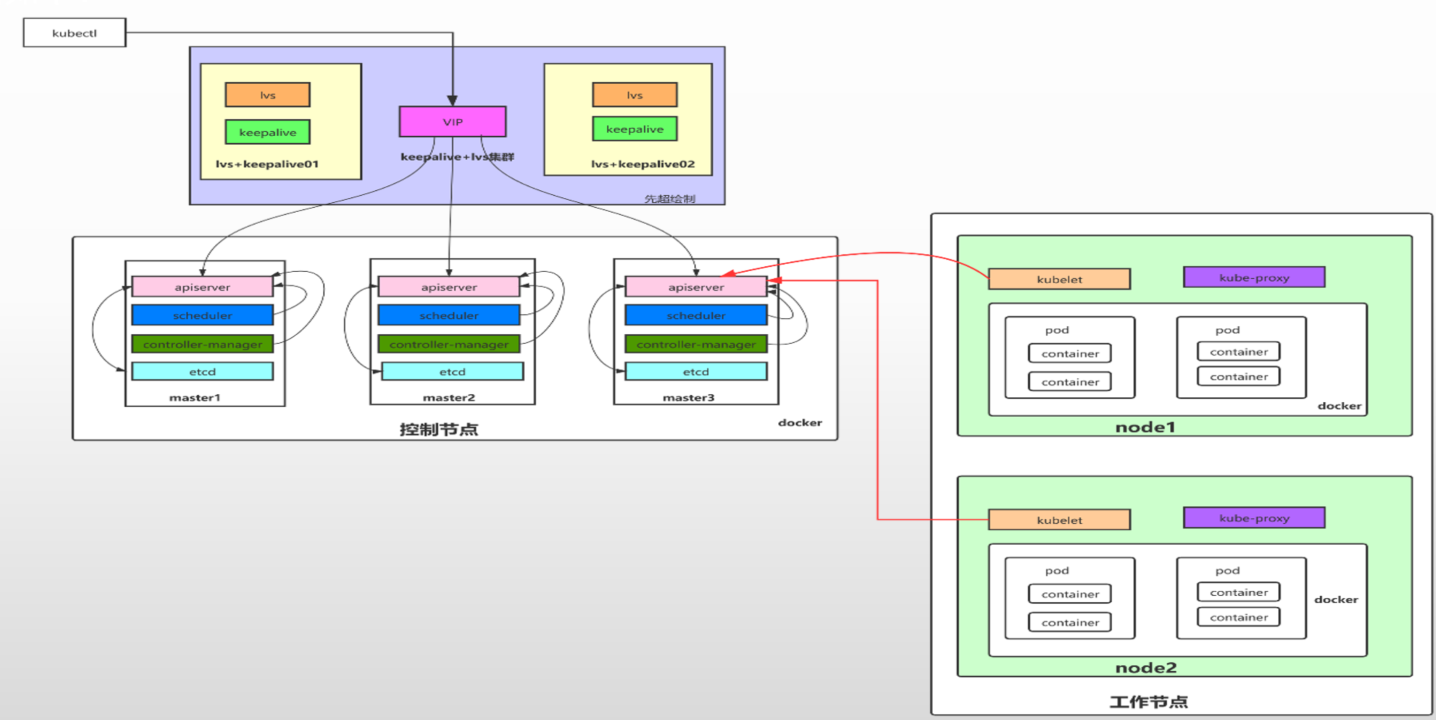

K8s 集群至少需要一个主节点 (Master) 和多个工作节点 (Worker),Master 节点是集群的控制节点,负责整个集群的管理和控制,主节点主要用于暴露 API,调度部署和节点的管理。工作节点主要是运行容器的。

多 master 节点高可用架构

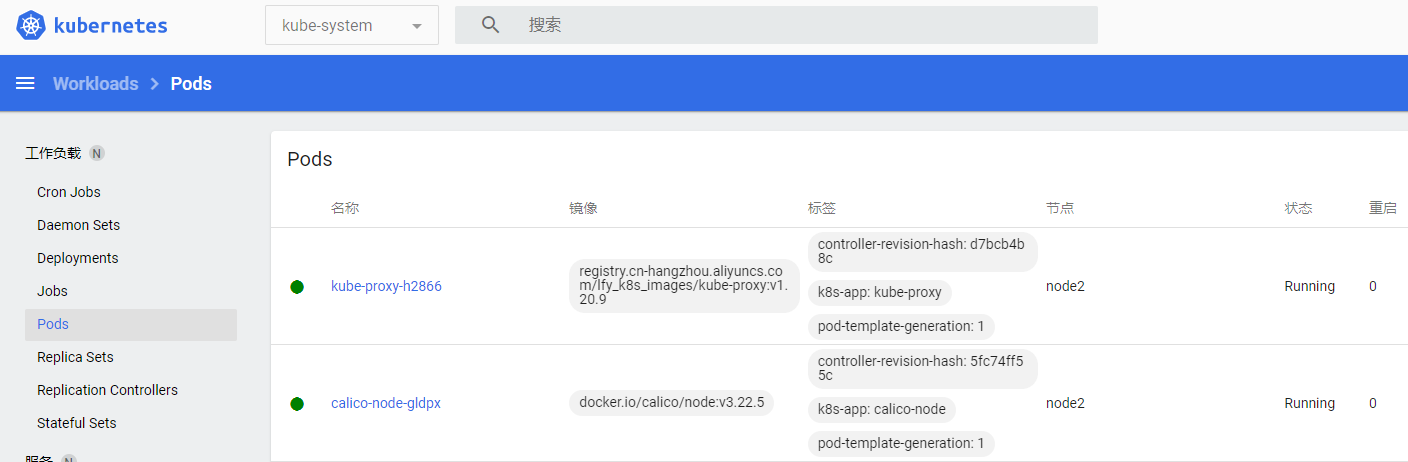

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 kubectl:管理K8s的命令行工具,可以操作K8s中的资源对象。 etcd: 是一个高可用的键值数据库,存储K8s的资源状态信息和网络信息的,etcd中的数据变更是通过api server进行的。 apiserver: 提供K8s api,是整个系统的对外接口,提供资源操作的唯一入口,供客户端和其它组件调用,提供了K8s各类资源对象(pod,deployment,Service等)的增删改查,是整个系统的数据总线和数据中心,并提供认证、授权、访问控制、API注册和发现等机制,并将操作对象持久化到etcd中。相当于“营业厅”。 scheduler:负责K8s集群中pod的调度的 , scheduler通过与apiserver交互监听到创建Pod副本的信息后,它会检索所有符合该Pod要求的工作节点列表,开始执行Pod调度逻辑。调度成功后将Pod绑定到目标节点上,相当于“调度室”。 controller-manager:与apiserver交互,实时监控和维护K8s集群的控制器的健康情况,对有故障的进行处理和恢复,相当于“大总管”。 kubelet: 每个Node节点上的kubelet定期就会调用API Server的REST接口报告自身状态,API Server接收这些信息后,将节点状态信息更新到etcd中。kubelet也通过API Server监听Pod信息,从而对Node机器上的POD进行管理,如创建、删除、更新Pod kube-proxy:提供网络代理和负载均衡,是实现service的通信与负载均衡机制的重要组件,kube-proxy负责为Pod创建代理服务,从apiserver获取所有service信息,并根据service信息创建代理服务,实现service到Pod的请求路由和转发,从而实现K8s层级的虚拟转发网络,将到service的请求转发到后端的pod上。 calico:网络插件,提供IP,策略隔离 coredns:域名解析

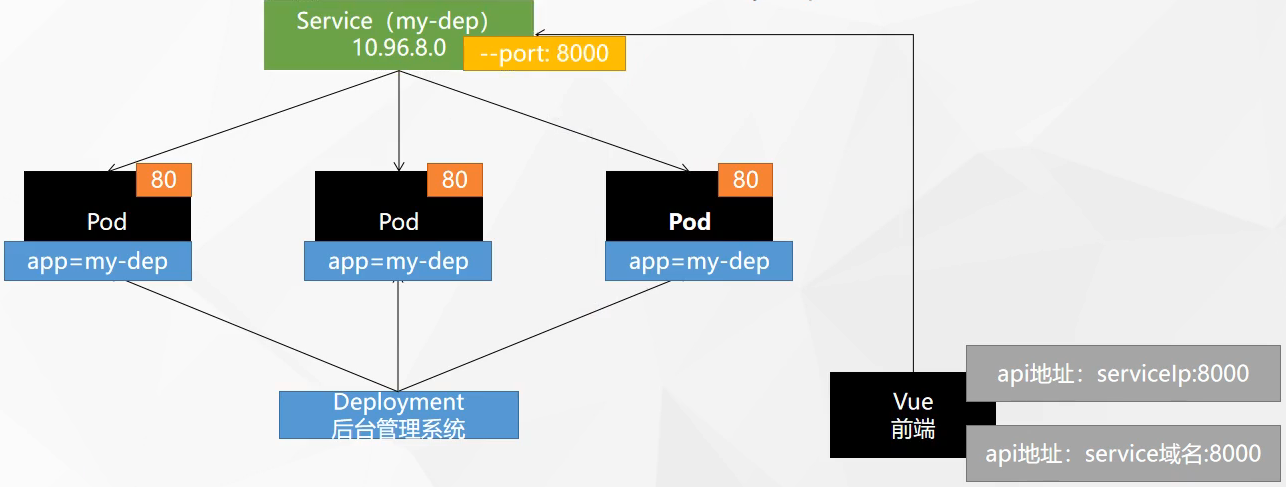

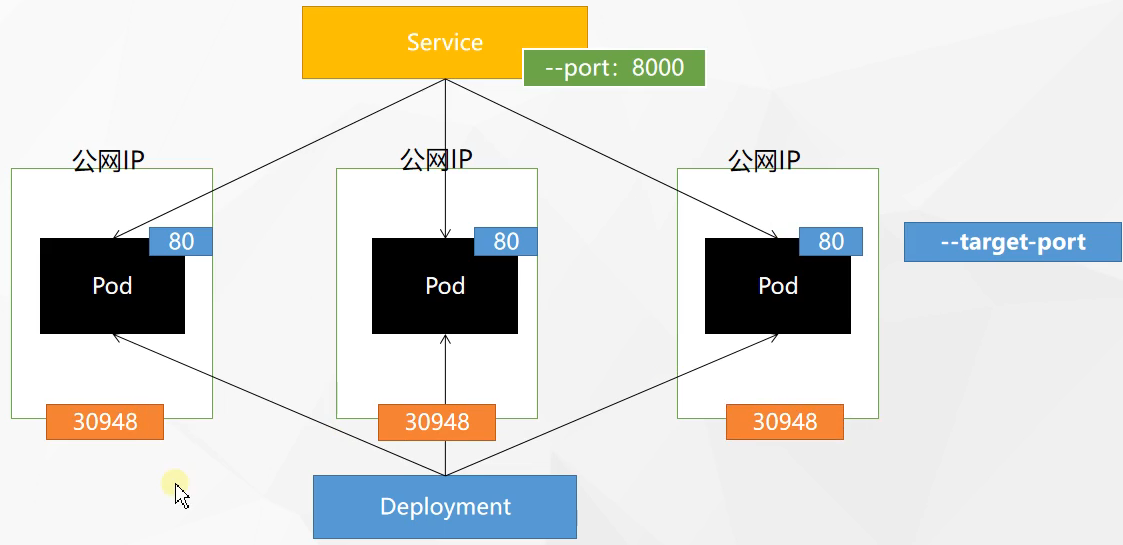

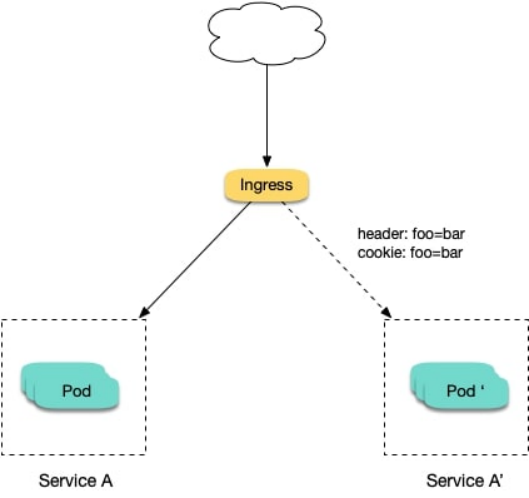

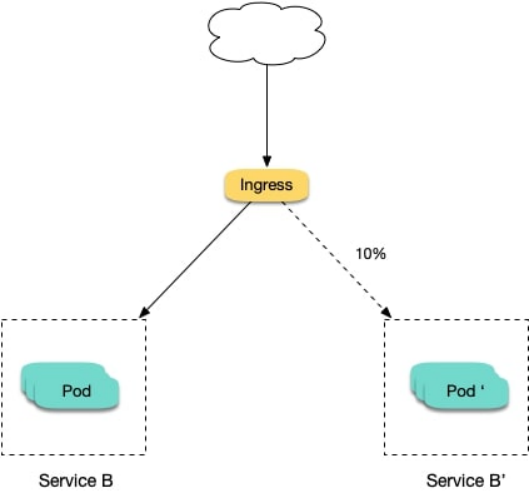

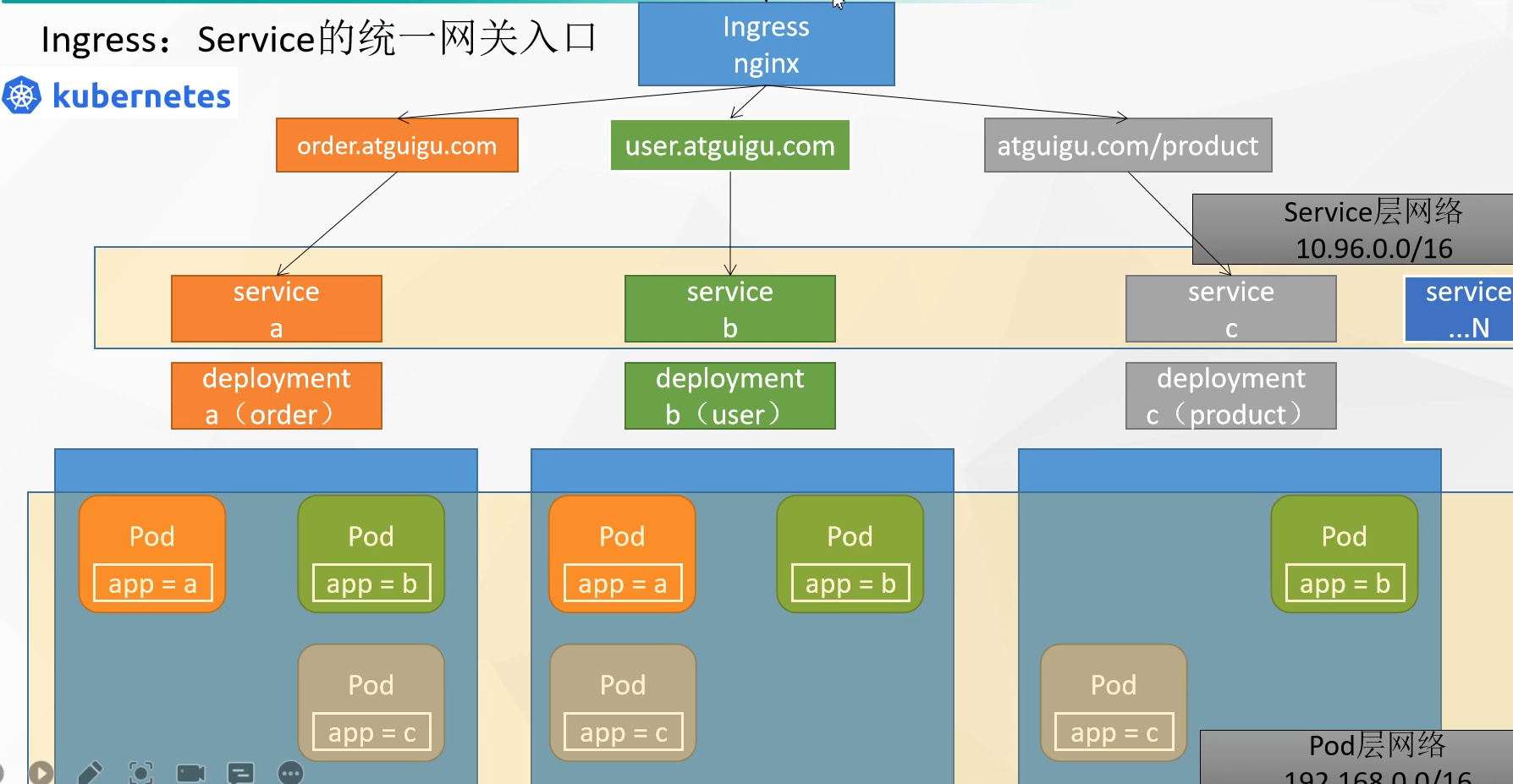

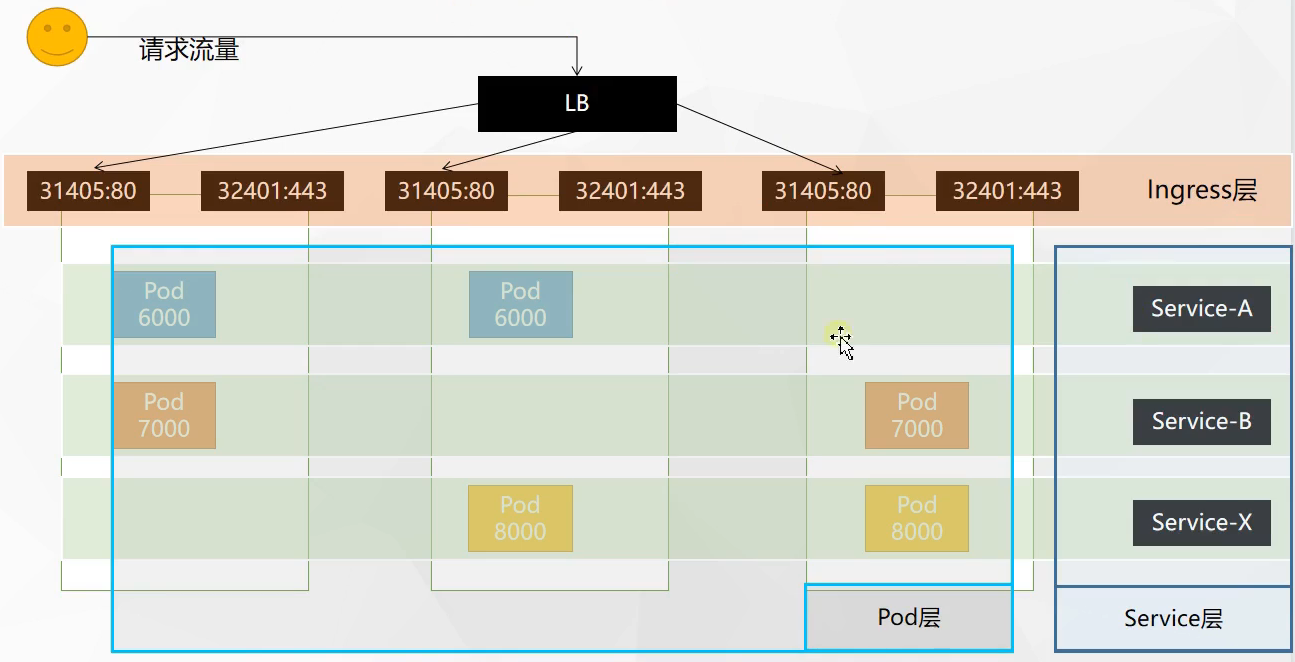

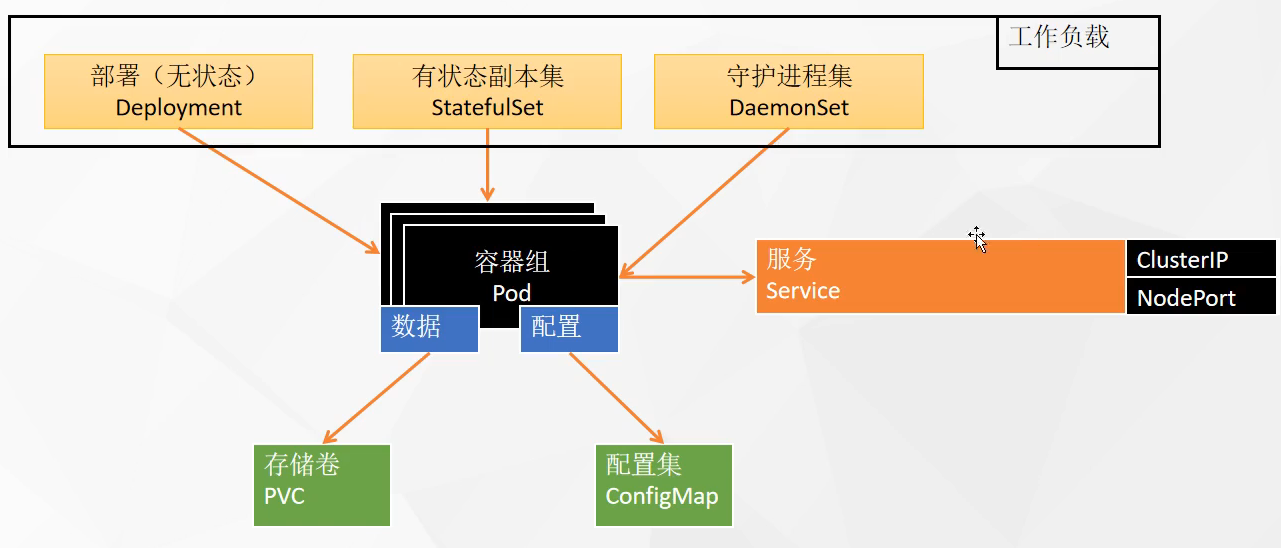

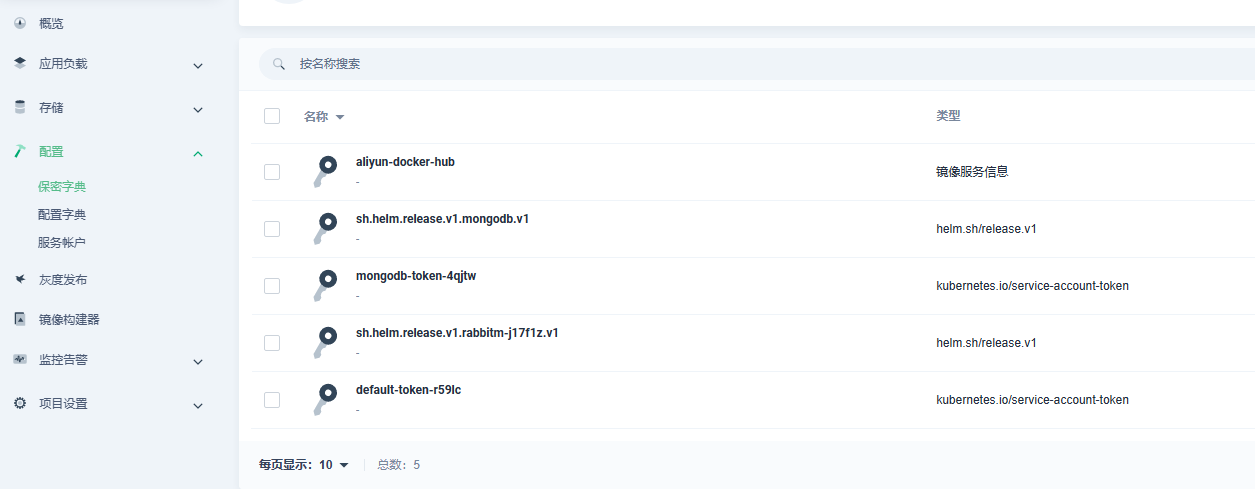

# 资源对象1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 Pod是Kubernetes中的最小调度单元,当指派容器时,容器实际上并不会指派到物理硬件上,容器会被分配到一个Pod里。Pod代表集群上正在运行的一个进程,一个Pod封装一个容器(也可以封装多个容器),Pod里的容器共享存储、网络等。也就是说,应该把整个pod看作虚拟机,然后每个容器相当于运行在虚拟机的进程。 Replicaset Kubernetes中的副本控制器,管理Pod,使pod副本的数量始终维持在预设的个数。 Deployment管理Replicaset和Pod的副本控制器,Deployment可以管理多个Replicaset,是比Replicaset更高级的控制器,也即是说在创建Deployment的时候,会自动创建Replicaset,由Replicaset再创建Pod,Deployment能对Pod扩容、缩容、滚动更新和回滚、维持Pod数量。 Service 在kubernetes中,Pod是有生命周期的,如果Pod重启IP很有可能会发生变化。如果我们的服务都是将Pod的IP地址写死,Pod的挂掉或者重启,和刚才重启的pod相关联的其他服务将会找不到它所关联的Pod,为了解决这个问题,在kubernetes中定义了service资源对象,Service 定义了一个服务访问的入口,客户端通过这个入口即可访问服务背后的应用集群实例,service是一组Pod的逻辑集合,这一组 Pod 能够被 Service 访问到,通常是通过 Label Selector实现的。 Statefulset Job & CronJob Ingress Configmap和Secret

开发代码 -> 提交代码到代码仓库 ->Jenkins 调 K8s API-> 动态生成 Jenkins Slave Pod->Slave Pod 拉取 git 上的代码 -> 编译代码 -> 打包镜像 -> 推送镜像到镜像仓库 harbor 或者 docker hub-> 通过 K8s 编排服务发布到测试、生产平台 -> Slave Pod 工作完成之后自动删除 > 通过 Ingress 发布服务。

# kubeadm 安装 k8s 多 master 高可用集群

kubeadm 是官方提供的开源工具,是一个开源项目,用于快速搭建 kubernetes 集群,目前是比较方便和推荐使用的。kubeadm init 以及 kubeadm join 这两个命令可以快速创建 kubernetes 集群。Kubeadm 初始化 k8s,所有的组件都是以 pod 形式运行的,具备故障自恢复能力。

kubeadm 是工具,可以快速搭建集群,也就是相当于用程序脚本帮我们装好了集群,属于自动部署,简化部署操作,自动部署屏蔽了很多细节,使得对各个模块感知很少,如果对 k8s 架构组件理解不深的话,遇到问题比较难排查。

kubeadm 适合需要经常部署 k8s,或者对自动化要求比较高的场景下使用。

二进制:在官网下载相关组件的二进制包,如果手动安装,对 kubernetes 理解也会更全面。

Kubeadm 和二进制都适合生产环境,在生产环境运行都很稳定,具体如何选择,可以根据实际项目进行评估。

1 2 ./configure --prefix=/usr/share/nginx --sbin-path=/usr/sbin/nginx --modules-path=/usr/lib64/nginx/modules --conf-path=/etc/nginx/nginx.conf --error-log-path=/var/log/nginx/error.log --http-log-path=/var/log/nginx/access.log --http-client-body-temp-path=/var/lib/nginx/tmp/client_body --http-proxy-temp-path=/var/lib/nginx/tmp/proxy --http-fastcgi-temp-path=/var/lib/nginx/tmp/fastcgi --http-uwsgi-temp-path=/var/lib/nginx/tmp/uwsgi --http-scgi-temp-path=/var/lib/nginx/tmp/scgi --pid-path=/run/nginx.pid --lock-path=/run/lock/subsys/nginx --user=nginx --group=nginx --with-compat --with-debug --with-file-aio --with-google_perftools_module --prefix= --with-http_addition_module --with-http_auth_request_module --with-http_dav_module --with-http_degradation_module --with-http_flv_module --with-http_gunzip_module --with-http_gzip_static_module --with-http_image_filter_module=dynamic --with-http_mp4_module --with-http_perl_module=dynamic --with-http_random_index_module --with-http_realip_module --with-http_secure_link_module --with-http_slice_module --with-http_ssl_module --with-http_stub_status_module --with-http_sub_module --with-http_v2_module --with-http_xslt_module=dynamic --with-mail=dynamic --with-mail_ssl_module --with-pcre --with-pcre-jit --with-stream=dynamic --with-stream_ssl_module --with-stream_ssl_preread_module --with-threads --with-cc-opt='-O2 -g -pipe -Wall -Wp,-D_FORTIFY_SOURCE=2 -fexceptions -fstack-protector-strong --param=ssp-buffer-size=4 -grecord-gcc-switches -specs=/usr/lib/rpm/redhat/redhat-hardened-cc1 -m64 -mtune=generic' --with-ld-opt='-Wl,-z,relro -specs=/usr/lib/rpm/redhat/redhat-hardened-ld -Wl,-E' --with-stream

1 2 3 4 5 auto eth0 iface eth0 inet static address 192.168.13.198 gateway 192.168.13.2 netmask 255.255.255.0

# 安装1. 安装 docker

2. 安装 kubelet

3. 安装 kubectl

4. 安装 kubeadm

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 预配环境: #各个机器设置自己的域名 hostnamectl set-hostname xxxx # 将 SELinux 设置为 permissive 模式(相当于将其禁用) sudo setenforce 0 sudo sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config #关闭swap swapoff -a sed -ri 's/.*swap.*/#&/' /etc/fstab #允许 iptables 检查桥接流量 cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf br_netfilter EOF cat <<EOF | sudo tee /etc/sysctl.d/k8s.conf net.bridge.bridge-nf-call-ip6tables = 1 net.bridge.bridge-nf-call-iptables = 1 EOF sudo sysctl --system

安装 kubelet、kubeadm、kubectl

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 cat <<EOF | sudo tee /etc/yum.repos.d/kubernetes.repo [kubernetes] name=Kubernetes baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64 enabled=1 gpgcheck=0 repo_gpgcheck=0 gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg exclude=kubelet kubeadm kubectl EOF sudo yum install -y kubelet-1.20.9 kubeadm-1.20.9 kubectl-1.20.9 --disableexcludes=kubernetes sudo systemctl enable --now kubelet

安装 kubelet、kubeadm、kubectl

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 sudo tee ./images.sh <<-'EOF' images=( kube-apiserver:v1.20.9 kube-proxy:v1.20.9 kube-controller-manager:v1.20.9 kube-scheduler:v1.20.9 coredns:1.7.0 etcd:3.4.13-0 pause:3.2 ) for imageName in ${images[@]} ; do docker pull registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images/$imageName done EOF chmod +x ./images.sh && ./images.sh

初始化主节点

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 echo "172.23.142.216 k8s-master" >> /etc/hostskubeadm init \ --apiserver-advertise-address=172.23.142.216 \ --control-plane-endpoint=k8s-master \ --image-repository registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images \ --kubernetes-version v1.20.9 \ --service-cidr=10.96.0.0/16 \ --pod-network-cidr=192.168.0.0/16 Your Kubernetes control-plane has initialized successfully! To start using your cluster, you need to run the following as a regular user: mkdir -p $HOME /.kube sudo cp -i /etc/kubernetes/admin.conf $HOME /.kube/config sudo chown $(id -u):$(id -g) $HOME /.kube/config Alternatively, if you are the root user, you can run: export KUBECONFIG=/etc/kubernetes/admin.conf You should now deploy a pod network to the cluster. Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at: https://kubernetes.io/docs/concepts/cluster-administration/addons/ You can now join any number of control-plane nodes by copying certificate authorities and service account keys on each node and then running the following as root: kubeadm join cluster-endpoint:6443 --token 902kx7.ic9ncjvtuksmf2rw \ --discovery-token-ca-cert-hash sha256:753403dbd24f4cef391a276ad67e8c9c8d91cec64467998426e3021123381b36 \ --control-plane Then you can join any number of worker nodes by running the following on each as root: kubeadm join cluster-endpoint:6443 --token 902kx7.ic9ncjvtuksmf2rw \ --discovery-token-ca-cert-hash sha256:753403dbd24f4cef391a276ad67e8c9c8d91cec64467998426e3021123381b36

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 主节点 mkdir -p $HOME /.kube sudo cp -i /etc/kubernetes/admin.conf $HOME /.kube/config sudo chown $(id -u):$(id -g) $HOME /.kube/config 主节点 下载calico https://docs.tigera.io/archive/v3.22/getting-started/kubernetes/self-managed-onprem/onpremises curl https://projectcalico.docs.tigera.io/archive/v3.22/manifests/calico.yaml -O kubectl apply -f calico.yaml [root@i-taf5qf6u ~] NAMESPACE NAME READY STATUS RESTARTS AGE kube-system calico-kube-controllers-57c7b58f66-jq7lm 0/1 ContainerCreating 0 22m kube-system calico-node-4bttn 1/1 Running 0 22m kube-system coredns-5897cd56c4-2fhkm 1/1 Running 0 55m kube-system coredns-5897cd56c4-2l59f 1/1 Running 0 55m kube-system etcd-master 1/1 Running 0 55m kube-system kube-apiserver-master 1/1 Running 0 55m kube-system kube-controller-manager-master 1/1 Running 0 55m kube-system kube-proxy-d4sgz 1/1 Running 0 55m kube-system kube-scheduler-master 1/1 Running 0 55m tigera-operator tigera-operator-57cb64cf85-kqsvh 1/1 Running 0 37m [root@i-taf5qf6u ~] NAME STATUS ROLES AGE VERSION master Ready control-plane,master 56m v1.20.9

1 2 3 4 5 6 7 8 9 kubectl get nodes kubectl appy -f xxx.yml kubectl get pods -A

1 2 3 kubeadm join cluster-endpoint:6443 --token 902kx7.ic9ncjvtuksmf2rw \ --discovery-token-ca-cert-hash sha256:753403dbd24f4cef391a276ad67e8c9c8d91cec64467998426e3021123381b36

1 2 kubeadm token create --print-join-command

==== new =====

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 apiserver controller-manager scheduler etcd kube-proxy docker calico coredns calico kubelet kube-proxy docker Swap是交换分区,如果机器内存不够,会使用swap分区,但是swap分区的性能较低,k8s设计的时候为了能提升性能,默认是不允许使用交换分区的。Kubeadm初始化的时候会检测swap是否关闭,如果没关闭,那就初始化失败。如果不想要关闭交换分区,安装k8s的时候可以指定--ignore-preflight-errors=Swap来解决。 free -m 1.24之后使用contained Kubeadm: kubeadm是一个工具,用来初始化k8s集群的 kubelet: 安装在集群所有节点上,用于启动Pod的 kubectl: 通过kubectl可以部署和管理应用,查看各种资源,创建、删除和更新各种组件 [root@master1 ~] apiVersion: v1 clusters: - cluster: certificate-authority-data: DATA+OMITTED server: https://192.168.13.249:16443 name: kubernetes contexts: - context: cluster: kubernetes user: kubernetes-admin name: kubernetes-admin@kubernetes current-context: kubernetes-admin@kubernetes kind: Config preferences: {} users :- name: kubernetes-admin user: client-certificate-data: REDACTED client-key-data: REDACTED kubeadm 在执行安装之前进行了相当细致的环境检测 1) 检查执行 init 命令的用户是否为 root,如果不是 root,直接快速失败(fail fast); 2) 检查待安装的 k8s 版本是否被当前版本的 kubeadm 支持(kubeadm 版本 >= 待安装 k8s 版本); 3) 检查防火墙,如果防火墙未关闭,提示开放端口 10250; 4) 检查端口是否已被占用,6443(或你指定的监听端口)、10257、10259; 5) 检查文件是否已经存在,/etc/kubernetes/manifests/*.yaml; 6) 检查是否存在代理,连接本机网络、服务网络、Pod网络,都会检查,目前不允许代理; 7) 检查容器运行时,使用 CRI 还是 Docker,如果是 Docker,进一步检查 Docker 服务是否已启动,是否设置了开机自启动; 8) 对于 Linux 系统,会额外检查以下内容: 8.1) 检查以下命令是否存在:crictl、ip、iptables、mount、nsenter、ebtables、ethtool、socat、tc、touch ; 8.2) 检查 /proc/sys/net/bridge/bridge-nf-call-iptables、/proc/sys/net/ipv4/ip-forward 内容是否为 1; 8.3) 检查 swap 是否是关闭状态; 9) 检查内核是否被支持,Docker 版本及后端存储 GraphDriver 是否被支持; 对于 Linux 系统,还需检查 OS 版本和 cgroup 支持程度(支持哪些资源的隔离); 10) 检查主机名访问可达性; 11) 检查 kubelet 版本,要高于 kubeadm 需要的最低版本,同时不高于待安装的 k8s 版本; 12) 检查 kubelet 服务是否开机自启动; 13) 检查 10250 端口是否被占用; 14) 如果开启 IPVS 功能,检查系统内核是否加载了 ipvs 模块; 15) 对于 etcd,如果使用 Local etcd,则检查 2379 端口是否被占用, /var/lib/etcd/ 是否为空目录; 如果使用 External etcd,则检查证书文件是否存在(CA、key、cert),验证 etcd 服务版本是否符合要求; 16) 如果使用 IPv6, 检查 /proc/sys/net/bridge/bridge-nf-call-iptables、/proc/sys/net/ipv6/conf/default/forwarding 内容是否为 1; 完成安装前的配置 1) 在 kube-system 命名空间创建 ConfigMap kubeadm-config,同时对其配置 RBAC 权限; 2) 在 kube-system 命名空间创建 ConfigMap kubelet-config-<version>,同时对其配置 RBAC 权限; 3) 为当前节点(Master)打标记:node-role.kubernetes.io/master=; 4) 为当前节点(Master)补充 Annotation; 5) 如果启用了 DynamicKubeletConfig 特性,设置本节点 kubelet 的配置数据源为 ConfigMap 形式; 6) 创建 BootStrap token Secret,并对其配置 RBAC 权限; 7) 在 kube-public 命名空间创建 ConfigMap cluster-info,同时对其配置 RBAC 权限; 8) 与 apiserver 通信,部署 DNS 服务; 9) 与 apiserver 通信,部署 kube-proxy 服务; 10) 如果启用了 self-hosted 特性,将 Control Plane 转为 DaemonSet 形式运行; 11) 打印 join 语句; Kubeadm生成的k8s证书内容说明: 一、证书分组 Kubernetes把证书放在了两个文件夹中 /etc/kubernetes/pki /etc/kubernetes/pki/etcd 二、Kubernetes 集群根证书 Kubernetes 集群根证书CA(Kubernetes集群组件的证书签发机构) /etc/kubernetes/pki/ca.crt /etc/kubernetes/pki/ca.key 以上这组证书为签发其他Kubernetes组件证书使用的根证书, 可以认为是Kubernetes集群中证书签发机构之一 由此根证书签发的证书有: 1、kube-apiserver apiserver证书 /etc/kubernetes/pki/apiserver.crt /etc/kubernetes/pki/apiserver.key 2、kubelet客户端证书, 用作 kube-apiserver 主动向 kubelet 发起请求时的客户端认证 /etc/kubernetes/pki/apiserver-kubelet-client.crt /etc/kubernetes/pki/apiserver-kubelet-client.key 三、kube-apiserver 代理根证书(客户端证书) 用在requestheader-client-ca-file配置选项中, kube-apiserver 使用该证书来验证客户端证书是否为自己所签发 /etc/kubernetes/pki/front-proxy-ca.crt /etc/kubernetes/pki/front-proxy-ca.key 由此根证书签发的证书只有一组: 代理层(如汇聚层aggregator)使用此套代理证书来向 kube-apiserver 请求认证 代理端使用的客户端证书, 用作代用户与 kube-apiserver 认证 /etc/kubernetes/pki/front-proxy-client.crt /etc/kubernetes/pki/front-proxy-client.key 三、etcd 集群根证书 etcd集群所用到的证书都保存在/etc/kubernetes/pki/etcd这路径下, 很明显, 这一套证书是用来专门给etcd集群服务使用的, 设计以下证书文件 etcd 集群根证书CA(etcd 所用到的所有证书的签发机构) /etc/kubernetes/pki/etcd/ca.crt /etc/kubernetes/pki/etcd/ca.key 由此根证书签发机构签发的证书有: 1、etcd server 持有的服务端证书 /etc/kubernetes/pki/etcd/server.crt /etc/kubernetes/pki/etcd/server.key 2、peer 集群中节点互相通信使用的客户端证书 /etc/kubernetes/pki/etcd/peer.crt /etc/kubernetes/pki/etcd/peer.key 注: Peer:对同一个etcd集群中另外一个Member的称呼 3、pod 中定义 Liveness 探针使用的客户端证书 kubeadm 部署的 Kubernetes 集群是以 pod 的方式运行 etcd 服务的, 在该 pod 的定义中, 配置了 Liveness 探活探针 /etc/kubernetes/pki/etcd/healthcheck-client.crt /etc/kubernetes/pki/etcd/healthcheck-client.key 当你 describe etcd 的 pod 时, 会看到如下一行配置: Liveness: exec [/bin/sh -ec ETCDCTL_API=3 etcdctl --endpoints=https://[127.0.0.1]:2379 --cacert=/etc/kubernetes/pki/etcd/ca.crt --cert=/etc/kubernetes/pki/etcd/healthcheck-client.crt --key=/etc/kubernetes/pki/etcd/healthcheck-client.key get foo] delay=15s timeout =15s period=10s 4、配置在 kube-apiserver 中用来与 etcd server 做双向认证的客户端证书 /etc/kubernetes/pki/apiserver-etcd-client.crt /etc/kubernetes/pki/apiserver-etcd-client.key

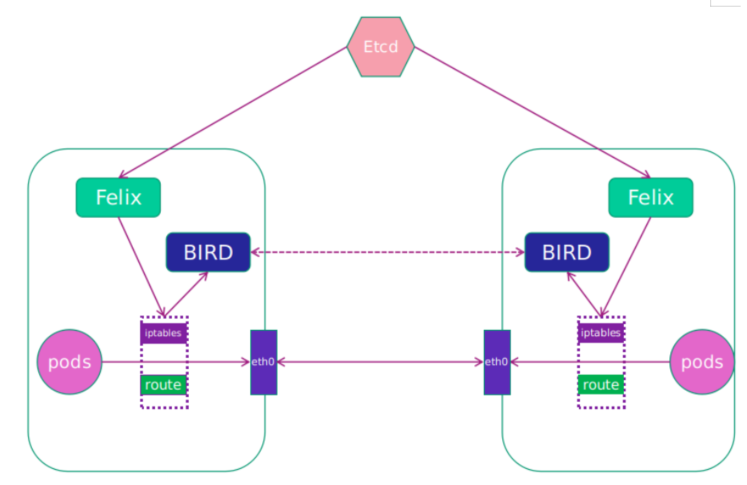

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 Calico网络模型主要工作组件: 1.Felix:运行在每一台 Host 的 agent 进程,主要负责网络接口管理和监听、路由、ARP 管理、ACL 管理和同步、状态上报等。保证跨主机容器网络互通。 2.etcd:分布式键值存储,相当于k8s集群中的数据库,存储着Calico网络模型中IP地址等相关信息。主要负责网络元数据一致性,确保 Calico 网络状态的准确性; 3.BGP Client(BIRD):Calico 为每一台 Host 部署一个 BGP Client,即每台host上部署一个BIRD。 主要负责把 Felix 写入 Kernel 的路由信息分发到当前 Calico 网络,确保 Workload 间的通信的有效性; 4.BGP Route Reflector:在大型网络规模中,如果仅仅使用 BGP client 形成 mesh 全网互联的方案就会导致规模限制,因为所有节点之间俩俩互联,需要 N^2 个连接,为了解决这个规模问题,可以采用 BGP 的 Router Reflector 的方法,通过一个或者多个 BGP Route Reflector 来完成集中式的路由分发。 扩展:calico的IPIP模式和BGP模式对比分析 1)IPIP 把一个IP数据包又套在一个IP包里,即把IP层封装到IP层的一个 tunnel,它的作用其实基本上就相当于一个基于IP层的网桥,一般来说,普通的网桥是基于mac层的,根本不需要IP,而这个ipip则是通过两端的路由做一个tunnel,把两个本来不通的网络通过点对点连接起来; calico以ipip模式部署完毕后,node上会有一个tunl0的网卡设备,这是ipip做隧道封装用的,也是一种overlay模式的网络。当我们把节点下线,calico容器都停止后,这个设备依然还在,执行 rmmodipip命令可以将它删除。 2)BGP BGP模式直接使用物理机作为虚拟路由路(vRouter),不再创建额外的tunnel 边界网关协议(BorderGateway Protocol, BGP)是互联网上一个核心的去中心化的自治路由协议。它通过维护IP路由表或‘前缀’表来实现自治系统(AS)之间的可达性,属于矢量路由协议。BGP不使用传统的内部网关协议(IGP)的指标,而是基于路径、网络策略或规则集来决定路由。因此,它更适合被称为矢量性协议,而不是路由协议,通俗的说就是将接入到机房的多条线路(如电信、联通、移动等)融合为一体,实现多线单IP; BGP 机房的优点:服务器只需要设置一个IP地址,最佳访问路由是由网络上的骨干路由器根据路由跳数与其它技术指标来确定的,不会占用服务器的任何系统; 常见网络插件 Flannel Calico Weave canal kubeadm init --config kubeadm.yaml --ignore-preflight-errors=SystemVerification apiVersion: kubeadm.k8s.io/v1beta2 kind: ClusterConfiguration kubernetesVersion: v1.20.6 controlPlaneEndpoint: 192.168.13.249:16443 imageRepository: registry.aliyuncs.com/google_containers apiServer: certSANs: - 192.168.13.211 - 192.168.13.177 - 192.168.13.188 - 192.168.13.249 networking: podSubnet: 10.244.0.0/16 serviceSubnet: 10.96.0.0/16 --- apiVersion: kubeproxy.config.k8s.io/v1alpha1 kind: KubeProxyConfiguration mode: ipvs kubectl label node xianchaonode1 node-role.kubernetes.io/worker=worker

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287 288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305 306 307 308 309 310 311 312 313 314 315 316 317 318 319 320 321 322 323 324 325 326 327 328 329 330 331 332 333 334 335 336 . /etc/init.d/functions ip= hostName=master dockerVersion=20.10.6 k8sVersion=1.23.0 podSubnet="10.244.0.0/16" serviceSubnet="10.10.0.0/16" openNetwork ping -c 1 www.baidu.com > /dev/null 2>&1 if [ $? -eq 0 ];then action "外网权限:" else action "外网权限:" echo "此脚本需要访问外网权限才可成功执行,退出脚本" exit 5 fi } stopFirewall systemctl disable firewalld --now &>/dev/null setenforce 0 &>/dev/null sed -i.$(date +%F) -r 's/SELINUX=[ep].*/SELINUX=disabled/g' /etc/selinux/config if (grep SELINUX=disabled /etc/selinux/config) &>/dev/null;then action "关闭防火墙:" else action "关闭防火墙:" false fi } hostName if [[ -z ${ip} ]];then ip=$(ip addr | grep -oP '(?<=inet\s)\d+\.\d+\.\d+\.\d+' |egrep -v "127.0.0.1|172.17.0.1" |awk NR==1) fi if [[ -z ${hostName} ]];then hostName="${HOSTNAME} " fi if ! (egrep -w "${ip} +${hostName} " /etc/hosts) &>/dev/null;then hostnamectl set-hostname ${hostName} echo "${ip} ${hostName} " >> /etc/hosts fi if (egrep -w "${ip} +${hostName} " /etc/hosts) &>/dev/null;then action "添加本地域名解析:" else action "添加本地域名解析:" false fi } timeSync if ! (which ntpdate &>/dev/null);then echo -e "\033[32m# ntpdate未安装,开始进行安装....\033[0m" (yum -y install ntpdate) &>/dev/null;sleep 0.3 if (which ntpdate &>/dev/null);then action "ntpdate安装成功:" fi fi if (ntpdate ntp1.aliyun.com &>/dev/null);then if ! (egrep "ntpdate +ntp1.aliyun.com" /var/spool/cron/root &>/dev/null);then echo "0 1 * * * ntpdate ntp1.aliyun.com" >> /var/spool/cron/root fi action "时间同步:" else action "时间同步:" false fi } swapOff swapoff --all sed -i -r '/swap/ s/^/#/' /etc/fstab if [[ $(free | grep -i swap | awk '{print $2}' ) -eq 0 ]]; then action "关闭交换分区:" else action "关闭交换分区:" false fi } addKernelArg KernelArg=("net.bridge.bridge-nf-call-ip6tables" "net.bridge.bridge-nf-call-iptables" "net.ipv4.ip_forward" ) for ((i=0;i<${#KernelArg[@]} ;i++))do if [[ $(sysctl -n ${KernelArg[i]} ) -ne 1 ]];then echo "${KernelArg[i]} = 1" >> /etc/sysctl.d/kubernetes.conf fi done modprobe br_netfilter &>/dev/null sysctl -p /etc/sysctl.d/kubernetes.conf &>/dev/null if [[ $(sysctl -n ${KernelArg[0]} ) -eq 1 && $(sysctl -n ${KernelArg[1]} ) -eq 1 && $(sysctl -n ${KernelArg[2]} ) -eq 1 ]]; then action "添加内核参数" else action "添加内核参数" false fi } ipvs if (command -v ipset &>/dev/null && command -v ipvsadm &>/dev/null);then cat > /etc/sysconfig/modules/ipvs.modules <<EOF modprobe -- ip_vs modprobe -- ip_vs_rr modprobe -- ip_vs_wrr modprobe -- ip_vs_sh modprobe -- nf_conntrack_ipv4 EOF chmod +x /etc/sysconfig/modules/ipvs.modules /etc/sysconfig/modules/ipvs.modules else echo -e "\033[32m# ipvs未安装,开始进行安装....\033[0m" yum -y install ipset ipvsadm &>/dev/null if (command -v ipset &>/dev/null && command -v ipvsadm &>/dev/null);then action "ipvs安装成功:" cat > /etc/sysconfig/modules/ipvs.modules <<EOF modprobe -- ip_vs modprobe -- ip_vs_rr modprobe -- ip_vs_wrr modprobe -- ip_vs_sh modprobe -- nf_conntrack_ipv4 EOF chmod +x /etc/sysconfig/modules/ipvs.modules /etc/sysconfig/modules/ipvs.modules fi fi modprobe br_netfilter &>/dev/null if (lsmod | grep -q -e ip_vs -e nf_conntrack_ipv4)&>/dev/null; then action "启用ipvs模块:" else action "启用ipvs模块:" false fi } dockerInstall if ! (command -v docker &>/dev/null);then echo -e "\033[32m# Docker未安装,开始进行安装....\033[0m" (curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repo) &>/dev/null (wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo) &>/dev/null (yum install -y yum-utils) &>/dev/null (yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo) &>/dev/null (yum install docker-ce-${dockerVersion} docker-ce-cli-${dockerVersion} -y) &>/dev/null if (command -v docker &>/dev/null);then action "Docker安装成功:" else action "Docker安装成功:" false fi fi mkdir /etc/docker &>/dev/nullif [[ -f /etc/docker/daemon.json ]];then mv /etc/docker/daemon.json{,.$(date +%F)} fi cat <<EOF > /etc/docker/daemon.json { "registry-mirrors": ["https://aoewjvel.mirror.aliyuncs.com"], "exec-opts": ["native.cgroupdriver=systemd"] } EOF (systemctl enable docker --now) &>/dev/null if [[ -f /etc/docker/daemon.json ]];then action "Docker镜像加速源:" else action "Docker镜像加速源:" fi } k8sInstall k8scommand=("kubeadm" "kubelet" "kubectl" ) if [[ -f /etc/yum.repos.d/kubernetes.repo ]];then mv /etc/yum.repos.d/kubernetes.repo{,.$(date +%F)} fi cat <<EOF > /etc/yum.repos.d/kubernetes.repo [kubernetes] name=Kubernetes baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/ enabled=1 gpgcheck=0 EOF echo -e "\033[32m# 正在安装K8S,请耐心等待......\033[0m" (yum -y install --setopt =obsoletes=0 kubeadm-${k8sVersion} kubelet-${k8sVersion} kubectl-${k8sVersion} ) &>/dev/null systemctl enable kubelet.service --now &>/dev/null for ((i=0;i<${#k8scommand[@]} ;i++))do if (command -v ${k8scommand[i]} &>/dev/null);then action "安装${k8scommand[i]} 组件:" else action "安装${k8scommand[i]} 组件:" false fi done } k8sInit if [[ -z ${ip} ]];then ip=$(grep ${HOSTNAME} /etc/hosts|awk '{print $1}' | awk NR==1) fi if [[ -f /root/kubeadm-config.yaml ]];then mv /root/kubeadm-config.yaml{,.$(date +%F)} fi cat >> /root/kubeadm-config.yaml << EOF apiVersion: kubeadm.k8s.io/v1beta3 bootstrapTokens: - groups: - system:bootstrappers:kubeadm:default-node-token token: abcdef.0123456789abcdef ttl: 24h0m0s usages: - signing - authentication kind: InitConfiguration localAPIEndpoint: advertiseAddress: ${ip} bindPort: 6443 nodeRegistration: imagePullPolicy: IfNotPresent name: node taints: null --- apiServer: timeoutForControlPlane: 4m0s apiVersion: kubeadm.k8s.io/v1beta3 certificatesDir: /etc/kubernetes/pki clusterName: kubernetes controllerManager: {} dns: {} etcd: local: dataDir: /var/lib/etcd imageRepository: registry.aliyuncs.com/google_containers kind: ClusterConfiguration kubernetesVersion: ${k8sVersion} networking: dnsDomain: cluster.local serviceSubnet: ${serviceSubnet} podSubnet: ${podSubnet} scheduler: {} --- apiVersion: kubeproxy.config.k8s.io/v1alpha1 kind: KubeProxyConfiguration mode: ipvs --- apiVersion: kubelet.config.k8s.io/v1beta1 kind: KubeletConfiguration cgroupDriver: systemd EOF if [[ -f /root/kubeadm-config.yaml ]];then action "生成K8s初始化文件:" else action "生成K8s初始化文件:" false fi echo -e "\033[32m# K8s初始化中,时间可能较长,可以使用 tailf k8s_init.log 可追踪整个过程....\033[0m" echo kubeadm init --config /root/kubeadm-config.yaml --ignore-preflight-errors=SystemVerification &>k8s_init.log if [[ $? -eq 0 ]];then action "K8s初始化:" mkdir -p $HOME /.kube sudo cp -i /etc/kubernetes/admin.conf $HOME /.kube/config sudo chown $(id -u):$(id -g) $HOME /.kube/config else action "K8s初始化:" false exit 5 fi } k8sNetwork (wget -O /root/calico.yaml http://120.48.34.146/calico.yaml) &>/dev/null (kubectl apply -f /root/calico.yaml) &>/dev/null if [[ $? -eq 0 ]];then action "K8s网络插件:" else action "K8s网络插件:" false fi } k8sTaint (kubectl taint nodes --all node-role.kubernetes.io/master-) &>/dev/null if [[ $? -eq 0 ]];then action "设置Master节点可调度:" else action "设置Master节点可调度:" false fi } initEnv clear;echo "一键部署单机版K8S脚本" openNetwork hostName stopFirewall swapOff timeSync ipvs addKernelArg dockerInstall } k8s clear;k8sInstall k8sInit k8sNetwork k8sTaint echo echo -e "\033[32m# K8s单机版部署完成,等待Pod全部运行成功即可使用 使用 kubectl get pods -n kube-system 关注Pod状态...\033[0m" bash } initEnv k8s

# 部署 dashboard1 kubectl apply -f https://raw.githubusercontent.com/kubernetes/dashboard/v2.3.1/aio/deploy/recommended.yaml

1 2 3 kubernetes-dashboard dashboard-metrics-scraper-79c5968bdc-24bws 1/1 Running 0 2m5s kubernetes-dashboard kubernetes-dashboard-658485d5c7-9hpsc 1/1 Running 0 2m5s

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 设置访问端口 kubectl edit svc kubernetes-dashboard -n kubernetes-dashboard :/type 改为 NodePort kubectl get svc -A |grep kubernetes-dashboard [root@master ~] kubernetes-dashboard dashboard-metrics-scraper ClusterIP 10.96.232.147 <none> 8000/TCP 6m7s kubernetes-dashboard kubernetes-dashboard NodePort 10.96.28.103 <none> 443:31882/TCP 6m7s [root@master ~] apiVersion: v1 kind: ServiceAccount metadata: name: admin-user namespace: kubernetes-dashboard --- apiVersion: rbac.authorization.k8s.io/v1 kind: ClusterRoleBinding metadata: name: admin-user roleRef: apiGroup: rbac.authorization.k8s.io kind: ClusterRole name: cluster-admin subjects: - kind: ServiceAccount name: admin-user namespace: kubernetes-dashboard [root@master ~] serviceaccount/admin-user created clusterrolebinding.rbac.authorization.k8s.io/admin-user created kubectl -n kubernetes-dashboard get secret $(kubectl -n kubernetes-dashboard get sa/admin-user -o jsonpath="{.secrets[0].name}" ) -o go-template="{{.data.token | base64decode}}" eyJhbGciOiJSUzI1NiIsImtpZCI6IkY5LU9Jc0pnblNNOVJhM1dlWVl6c09DTjNnbFNQa1hzcWhOSThHVENEdlUifQ.eyJpc3MiOiJrdWJlcm5ldGVzL3NlcnZpY2VhY2NvdW50Iiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9uYW1lc3BhY2UiOiJrdWJlcm5ldGVzLWRhc2hib2FyZCIsImt1YmVybmV0ZXMuaW8vc2VydmljZWFjY291bnQvc2VjcmV0Lm5hbWUiOiJhZG1pbi11c2VyLXRva2VuLXp3NmRzIiwia3ViZXJuZXRlcy5pby9zZXJ2aWNlYWNjb3VudC9zZXJ2aWNlLWFjY291bnQubmFtZSI6ImFkbWluLXVzZXIiLCJrdWJlcm5ldGVzLmlvL3NlcnZpY2VhY2NvdW50L3NlcnZpY2UtYWNjb3VudC51aWQiOiJkOTRmMDZlNi1kNTkxLTRmMzktODMxNC0zNzI2MDVhM2RkN2MiLCJzdWIiOiJzeXN0ZW06c2VydmljZWFjY291bnQ6a3ViZXJuZXRlcy1kYXNoYm9hcmQ6YWRtaW4tdXNlciJ9.TMTc8QDTIo3qhsGTYD05c8txOyq2op7xW9ZQB5ICVw5x4fg-L0iUnn1jGyo4REP6ci63zBR-xmirqHy1eQ5GgT1nwGZnv4oKqNElm8-wkAit5rEgVN7ATo5GN3VrRQgNyBsHwqFhe1SsrK47flCZcmBvWbgmU4ugFfrNZ8xHkSURKrLAPUPjsYUC6ugyrEMqfwhcxzMiZcSKxG20jjLgVK7Pd_T01NAObUb_lCjq7mrEV0KdHcYTtSYwVwV88mTu5vwb39k-10V0s6HOqiDx87lp7fPtctrcR3mRiT1PkEvsyhCb8qAuFDPuaJZtESFu2dCXP_fVmv5g7AhSO_qUHg

如果页面没有接受风险,换浏览器或者空白输入 thisisunsafe

通过 token 访问 dashboard

1 2 3 4 [root@master1 ~] [root@master1 ~] [root@master1 ~]

通过 kubeconfig 访问 dashborad

1 2 3 4 5 6 7 cd /etc/kubernetes/pki/kubectl config set-cluster kubernetes --certificate-authority=./ca.crt --server="https://192.168.40.249:6443" --embed-certs=true --kueconfig=/root/dashboard-admin.conf DEF_NS_ADMIN_TOKEN=$(kubectl get secret kubernetes-dashboard-token-dmv8x -n kubernetes-dashboard -o jsonpath={.data.token}|base64 -d kubectl config set-credentials dashboard-admin --token=$DEF_NS_ADMIN_TOKEN --kubeconfig=/root/dashboard-admin.conf kubectl config set-context dashboard-admin@kubernetes --cluster=kubernetes --user=dashboard-admin --kubeconfig=/root/dashboard-admin.onf kubectl config use-context dashboard-admin@kubernetes --kubeconfig=/root/dashboard-admin.conf vim /root/dashboard-admin.conf

# 安装 containerd对于 1.24 以上的版本,使用 containerd 管理和运行容器,在此版本之前使用的是 docker

Kubernetes 中的容器运行时就像一个保姆一样,它负责管理容器的生命周期和资源隔离,确保容器能够在节点上稳定地运行。其中,containerd 就是一个常用的容器运行时,它实现了 Kubernetes 规定的 CRI 接口,因此可以被 Kubernetes 作为容器运行时来使用。简单来说,就是 Kubernetes 需要容器运行时来管理和运行容器,而 containerd 就是 Kubernetes 中常用的一种容器运行时,能够让 Kubernetes 更加高效、稳定地运行容器化应用。

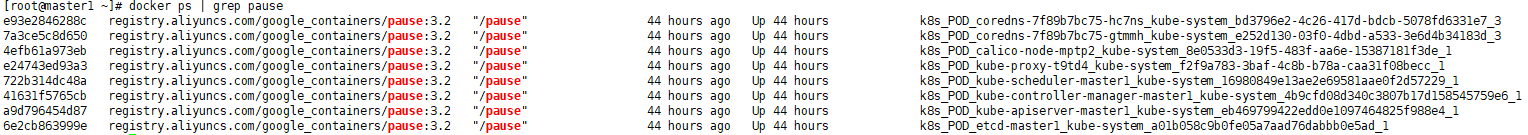

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 yum install containerd.io-1.6.6 -y mkdir -p /etc/containerdcontainerd config default > /etc/containerd/config.toml vim /etc/containerd/config.toml SystemdCgroup = true sandbox_image="registry.aliyuncs.com/google_containers/pause:3.7" 相比 cgroupfs,systemd-cgroup 在资源隔离方面提供了更好的性能和更多的特性。例如,systemd-cgroup 可以使用更多的内存压缩算法,以便更有效地使用内存。此外,systemd-cgroup 还提供了更好的 cgroup 监控和控制机制,可以更精确地调整容器的资源使用量。 总之,使用 systemd-cgroup 作为容器运行时的 cgroup 驱动程序,可以提高 Kubernetes 集群中容器的资源管理效率,从而提升整个集群的性能。 在 Kubernetes 中,每个 Pod 中都有一个 pause 容器,这个容器不会运行任何应用,只是简单地 sleep 。它的作用是为了保证 Pod 中所有的容器共享同一个网络命名空间和 IPC 命名空间。pause 容器会在 Pod 的初始化过程中首先启动,然后为 Pod 中的其他容器创建对应的网络和 IPC 命名空间,并且在其他容器启动之前保持运行状态,以保证其他容器可以加入到共享的命名空间中。 简单来说,pause 容器就是一个占位符,它为 Pod 中的其他容器提供了一个共享的环境,使它们可以共享同一个网络和 IPC 命名空间。这也是 Kubernetes 实现容器间通信和网络隔离的重要机制之一。 创建/etc/crictl.yaml文件 [root@xianchaomaster1 ~] runtime-endpoint: unix:///run/containerd/containerd.sock image-endpoint: unix:///run/containerd/containerd.sock timeout : 10debug: false EOF 这个文件是 crictl 工具的配置文件,用于指定与 containerd 交互的相关设置: 指定unix:///run/containerd/containerd.sock 是为了告诉 crictl 使用 Unix 域套接字的方式来连接 containerd 的 API。containerd 提供了一个 socket 文件 /run/containerd/containerd.sock,crictl 通过连接该 socket 文件,可以与 containerd 进行通信,管理容器和镜像等操作。 1)runtime-endpoint:指定 containerd 的运行时接口地址,以便 crictl 可以与 containerd 通信来管理容器生命周期和资源隔离。 2)image-endpoint:指定 containerd 的镜像接口地址,以便 crictl 可以与 containerd 通信来管理镜像的拉取和推送。 3)timeout :指定 crictl 等待 containerd 响应的最大时间,避免出现无响应的情况。 4)debug:开启或关闭 crictl 的调试模式,方便排查问题。 配置containerd镜像加速器,k8s所有节点均按照以下配置: 编辑vim /etc/containerd/config.toml文件 找到config_path = "" ,修改成如下目录: config_path = "/etc/containerd/certs.d" mkdir /etc/containerd/certs.d/docker.io/ -pvim /etc/containerd/certs.d/docker.io/hosts.toml [host."https://vh3bm52y.mirror.aliyuncs.com" ,host."https://registry.docker-cn.com" ] capabilities = ["pull" ,"push" ] 重启containerd: systemctl restart containerd yum install docker-ce -y vim /etc/docker/daemon.json 写入如下内容: { "registry-mirrors" :["https://vh3bm52y.mirror.aliyuncs.com" ,"https://registry.docker-cn.com" ,"https://docker.mirrors.ustc.edu.cn" ,"https://dockerhub.azk8s.cn" ,"http://hub-mirror.c.163.com" ] } 重启docker: systemctl restart docker

1 2 3 1.ctr是containerd自带的CLI命令行工具,crictl是k8s中CRI(容器运行时接口)的客户端,k8s使用该客户端和containerd进行交互; 2.ctr和crictl命令具体区别如下,也可以--help查看。crictl缺少对具体镜像的管理能力,可能是k8s层面镜像管理可以由用户自行控制,能配置pod里面容器的统一镜像仓库,镜像的管理可以有habor

1 2 3 K8s官方文档:https://kubernetes.io/ K8s中文官方文档: https://kubernetes.io/zh/ K8s Github地址:https://github.com/kubernetes/kubernetes

# NamespaceKubernetes 支持多个虚拟集群,它们底层依赖于同一个物理集群。 这些虚拟集群被称为命名空间。

命名空间 namespace 是 k8s 集群级别的资源,可以给不同的用户、租户、环境或项目创建对应的命名空间

命名空间适用于存在很多跨多个团队或项目的用户的场景。默认存放在 default 空间下

隔离资源,不隔离网络

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 [root@master ~] NAME STATUS AGE calico-system Active 41h default Active 41h kube-node-lease Active 41h kube-public Active 41h kube-system Active 41h kubernetes-dashboard Active 27m tigera-operator Active 41h [root@master ~] [root@master ~] [root@master ~] kubectl delete ns 111 kubectl create ns 111 kubectl get ns apiVersion: v1 kind: Namespace metadata: name: hello kubectl explain ResourceQuota apiVersion: v1 kind: ResourceQuota metadata: name: mem-cpu-quota namespace: testing spec: hard: requests.cpu: "2" requests.memory: 2Gi limits.cpu: "4" limits.memory: 4Gi [root@master1 ~] NAME AGE REQUEST LIMIT mem-cpu-quota 18s requests.cpu: 0/2, requests.memory: 0/1Gi limits.cpu: 0/4, limits.memory: 0/2Gi request node必须有空闲的request指定的内存才会调度pod到该node上 limit 是限制不能超过指定的内存和CPUapiVersion: v1 kind: Pod metadata: name: pod-test namespace: test labels: app: tomcat-pod-test spec: containers: - name: tomcat-test ports: - containerPort: 8080 image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent resources: requests: memory: "100Mi" cpu: "500m" limits: memory: "2Gi" cpu: "2"

# pod运行中的一组容器,Pod 是 kubernetes 中应用的最小调度单元 k8s 是通过定义一个 Pod 的资源,然后在 Pod 里面运行容器,容器需要指定一个镜像,这样就可以用来运行具体的服务。

一个 Pod 封装一个容器(也可以封装多个容器),Pod 里的容器共享存储、网络等 。也就是说,应该把整个 pod 看作虚拟机,然后每个容器相当于运行在虚拟机的进程。

Pod 是需要调度到 k8s 集群的工作节点来运行的,具体调度到哪个节点,是根据 scheduler 调度器实现的。

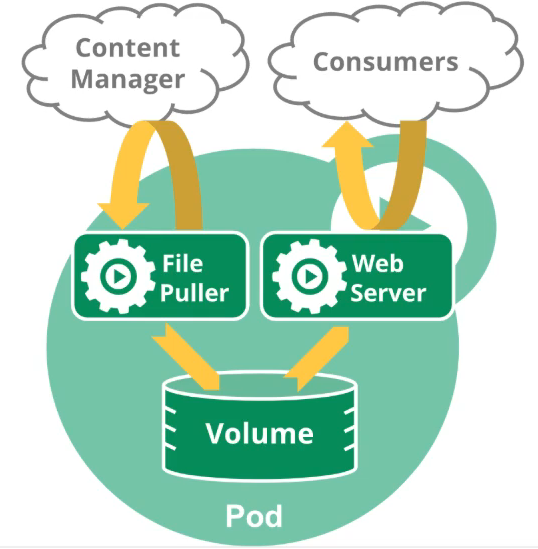

# pod 管理多个容器pod 之间隔离,pod 中可以运行多个容器,pod 中共享资源

Pod 中可以同时运行多个容器。同一个 Pod 中的容器会自动的分配到同一个 node 上。同一个 Pod 中的容器共享资源、网络环境,它们总是被同时调度,在一个 Pod 中同时运行多个容器是一种比较高级的用法,只有当你的容器需要紧密配合协作的时候才考虑用这种模式。

例如,你有一个容器作为 web 服务器运行,需要用到共享的 volume,有另一个 “sidecar” 容器来从远端获取资源更新这些文件。

一些 Pod 有 init 容器和应用容器。 在应用程序容器启动之前,运行初始化容器。比如 es 就需要有 init 容器修改 es 内核参数

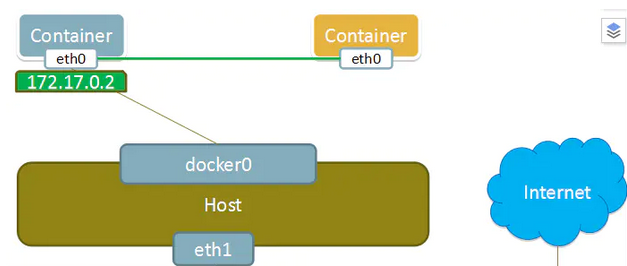

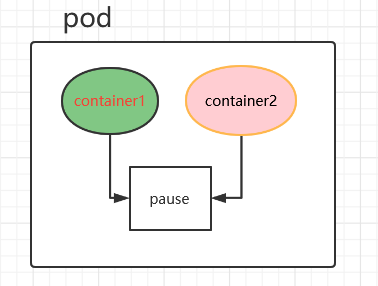

# Pod 网络1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 [root@master1 pki] NAMESPACE NAME READY STATUS RESTARTS AGE IP NODE default nginx-7f466444dc-jbhpm 1/1 Running 0 77m 10.244.166.134 node1 <none> kube-system calico-kube-controllers-57c7b58f66-b7pw7 1/1 Running 0 24h 10.244.166.132 node1 <none> kube-system calico-node-fdzw9 1/1 Running 1 24h 192.168.13.188 master2 <none> kube-system calico-node-hz96l 1/1 Running 1 24h 192.168.13.199 node1 <none> Pod是有IP地址的,假如pod不是共享物理机ip,由网络插件(calico、flannel、weave)划分的ip,每个pod都被分配唯一的IP地址 控制节点组件 pod ip和物理机ip一样 如果pod由calico分配,且不共享物理机IP,那么IP唯一,ip地址段在配置时指定 docker 容器间通信,通过--net container参数,指定其和已经存在的某个容器共享一个 Network Namespace。 docker run --name container2 --net=container:none -it --privileged=true centos Kubernetes中容器共享的方式 在k8s中,启动Pod时,会先启动⼀个pause 的容器,然后将后续的所有容器都 link 到这个pause 的容器,以实现⽹络共享

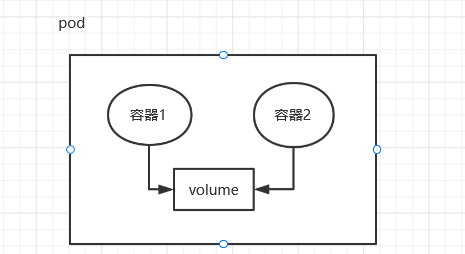

# pod 存储创建 Pod 的时候可以指定挂载的存储卷。 POD 中的所有容器都可以访问共享卷,允许这些容器共享数据。 Pod 只要挂载持久化数据卷,Pod 重启之后数据还是会存在的

volume 可以是 nfs,cefs,或者云存储

Pod 中的所用容器会被一致调度、同节点部署,并且在一个 “共享环境” 中运行。

1)所有容器共享一个 IP 地址和端口空间,意味着容器之间可以通过 localhost 高效访问,不能有端口冲突

2)允许容器之间共享存储卷,通过文件系统交互信息

些容器需要紧密联系,需要一起工作。Pod 提供了比容器更高层次的抽象, Pod 中的所有容器使用同一个网络的 namespace,即相同的 IP 地址和 Port 空间。它们可以直接用 localhost 通信。同样的,这些容器可以共享存储,当 K8s 挂载 Volume 到 Pod 上,本质上是将 volume 挂载到 Pod 中的每一个容器里。

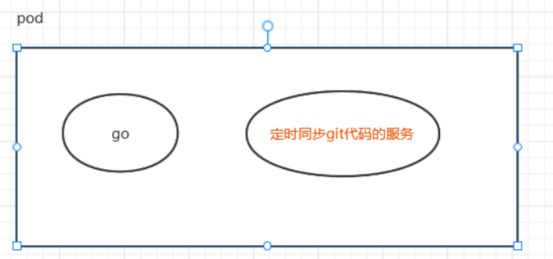

通过 pod 可以实现代码自动更新和日志收集

1 生产环境部署了一个go的应用,而且部署了几百个节点,希望这个应用可以定时的同步最新的代码,以便自动升级线上环境。这时,我们不希望改动原来的go应用,可以开发一个Git代码仓库的自动同步服务,然后通过Pod的方式进行编排,并共享代码目录,就可以达到更新java应用代码的效果。

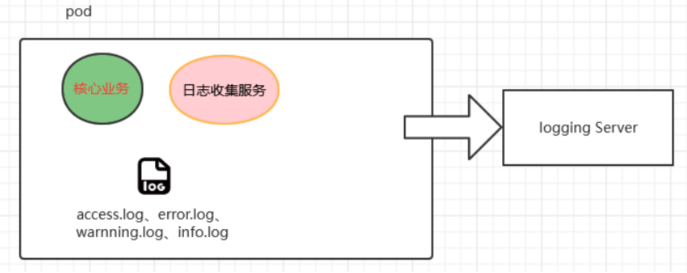

pod 实现日志收集并 aggregate

使用 Pod 的方式,通过简单的编排,既可以保持原有服务逻辑、部署方式不变,又可以增加新的日志收集服务。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 1. kubectl run 命令行创建 (不常用) 2. yaml文件创建 1 .自主式pod:直接定义一个pod资源 apiVersion: v1 kind: Pod metadata: name: tomcat-test namespace: default labels: app: tomcat spec: containers: - name: tomcat-java ports: - containerPort: 8080 image: tomcat:latest imagePullPolicy: IfNotPresent [root@master1 ~ ] [root@master1 ~ ] NAMESPACE NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES default tomcat-test 0 /1 ContainerCreating 0 66s <none> node1 <none> <none> pod被删之后不会在重启 kubectl delete pod 2 .控制器管理pod 常见的管理Pod的控制器:Replicaset、Deployment、Job、CronJob、Daemonset、Statefulset。 控制器管理的Pod可以确保Pod始终维持在指定的副本数运行。 kind: Deployment、Job... apiVersion: apps/v1 kind: Deployment metadata: name: nginx-test labels: app: nginx-deploy spec: selector: matchLabels: app: nginx replicas: 2 template: metadata: labels: app: nginx spec: containers: - name: my-nginx image: xianchao/nginx:v1 imagePullPolicy: IfNotPresent ports: - containerPort: 80

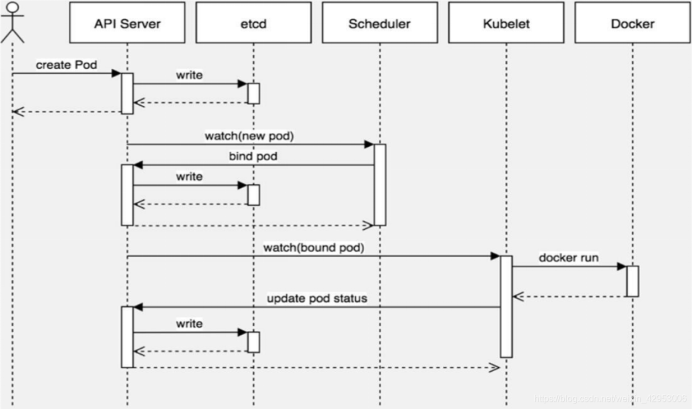

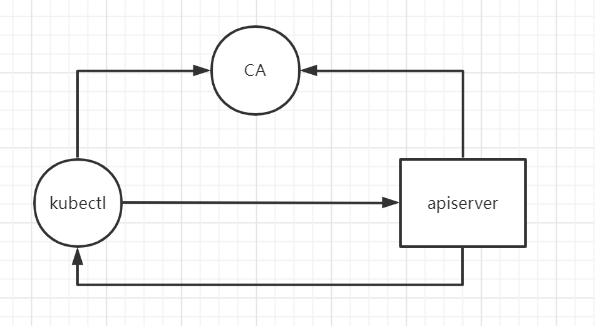

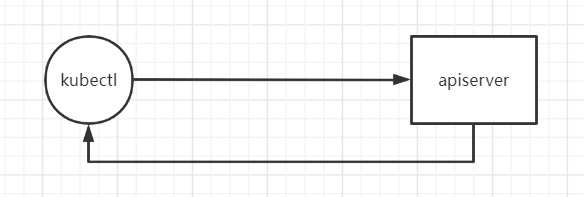

# pod 创建机制kubectl 执行的时候先找 kubeconfig 的环境变量,如果没有就找~/.kube/config

kubectl config view 查看不带 key 的 config

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 [root@master1 ~ ] apiVersion: v1 clusters: - cluster: certificate-authority-data: DATA+OMITTED server: https://192.168.13.249:16443 name: kubernetes contexts: - context: cluster: kubernetes user: kubernetes-admin name: kubernetes-admin@kubernetes current-context: kubernetes-admin@kubernetes kind: Config preferences: {}users: - name: kubernetes-admin user: client-certificate-data: REDACTED client-key-data: REDACTED

1 2 3 4 5 6 7 8 9 10 11 12 13 14 kubectl apply -f nginx-deploy.yaml->找到config文件,基于config文件指定的用户访问指定的集群,这样就找到了apiserver 第一步: 通过 kubectl 命令向 apiserver 提交创建pod的请求,apiserver接收到pod创建请求后,会将pod的属性信息(metadata)写入etcd。 第二步: apiserver触发watch机制准备创建pod,信息转发给调度器scheduler,调度器使用调度算法选择node,调度器将node信息给apiserver,apiserver将绑定的node信息写入etcd 第三步: apiserver又通过watch机制,调用kubelet,指定pod信息,调用容器运行时创建并启动pod内的容器。 第四步: 创建完成之后反馈给kubelet, kubelet又将pod的状态信息给apiserver, apiserver又将pod的状态信息写入etcd。

# yaml 创建 pod1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 [root@master2 ~ ] KIND: Pod VERSION: v1 DESCRIPTION: Pod is a collection of containers that can run on a host. This resource is created by clients and scheduled onto hosts. FIELDS: apiVersion <string> APIVersion defines the versioned schema of this representation of an object. Servers should convert recognized schemas to the latest internal value, and may reject unrecognized values. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#resources kind <string> Kind is a string value representing the REST resource this object represents. Servers may infer this from the endpoint the client submits requests to. Cannot be updated. In CamelCase. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#types-kinds metadata <Object> Standard object's metadata. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#metadata spec <Object> Specification of the desired behavior of the pod. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#spec-and-status status <Object> Most recently observed status of the pod. This data may not be up to date. Populated by the system. Read-only. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#spec-and-status [root@master2 ~ ] KIND: Pod VERSION: v1 RESOURCE: metadata <Object> DESCRIPTION: Standard object's metadata. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#metadata ObjectMeta is metadata that all persisted resources must have, which includes all objects users must create. FIELDS: annotations <map[string]string> Annotations is an unstructured key value map stored with a resource that may be set by external tools to store and retrieve arbitrary metadata. They are not queryable and should be preserved when modifying objects. More info: http://kubernetes.io/docs/user-guide/annotations [root@master2 ~ ] KIND: Pod VERSION: v1 RESOURCE: spec <Object> DESCRIPTION: Specification of the desired behavior of the pod. More info: https://git.k8s.io/community/contributors/devel/sig-architecture/api-conventions.md#spec-and-status PodSpec is a description of a pod. FIELDS: activeDeadlineSeconds <integer> Optional duration in seconds the pod may be active on the node relative to StartTime before the system will actively try to mark it failed and kill associated containers. Value must be a positive integer. affinity <Object> If specified, the pod's scheduling constraints [root@master2 ~ ] KIND: Pod VERSION: v1 RESOURCE: containers <[]Object> DESCRIPTION: List of containers belonging to the pod. Containers cannot currently be added or removed. There must be at least one container in a Pod. Cannot be updated. A single application container that you want to run within a pod. FIELDS: args <[]string> Arguments to the entrypoint. The docker image's CMD is used if this is not provided. Variable references $(VAR_NAME) are expanded using the container's environment. If a variable cannot be resolved, the reference in the input string will be unchanged. The $(VAR_NAME) syntax can be escaped with a double $$, ie: $$(VAR_NAME). Escaped references will never be expanded, regardless of whether the variable exists or not. Cannot be updated. More info: https://kubernetes.io/docs/tasks/inject-data-application/define-command-argument-container/#running-a-command-in-a-shell [root@master2 ~ ] KIND: Pod VERSION: v1 RESOURCE: ports <[]Object> DESCRIPTION: List of ports to expose from the container. Exposing a port here gives the system additional information about the network connections a container uses, but is primarily informational. Not specifying a port here DOES NOT prevent that port from being exposed. Any port which is listening on the default "0.0.0.0" address inside a container will be accessible from the network. Cannot be updated. ContainerPort represents a network port in a single container. FIELDS: containerPort <integer> -required- Number of port to expose on the pod's IP address. This must be a valid port number, 0 < x < 65536 . [root@master1 ~ ] apiVersion: v1 apiVersion: v1 kind: Pod metadata: labels: app: tomcat name: tomcat-cattt namespace: default spec: activeDeadlineSeconds: 10000 containers: - name: tomcat-doggg image: tomcat:9.0 imagePullPolicy: IfNotPresent ports: - containerPort: 8080 [root@master1 ~ ]

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 [root@master ~] NAMESPACE NAME READY STATUS RESTARTS AGE default mynginx 1/1 Running 0 84s [root@master ~] Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Scheduled 2m17s default-scheduler Successfully assigned default/mynginx to node2 Normal Pulling 2m16s kubelet Pulling image "nginx" Normal Pulled 71s kubelet Successfully pulled image "nginx" in 1m5.193735599s Normal Created 67s kubelet Created container mynginx Normal Started 67s kubelet Started container mynginx [root@master ~] [root@master ~] [root@master1 ~] [root@master1 ~] [root@master ~] apiVersion: v1 kind: Pod metadata: labels: run: mynginx name: mynginx spec: containers: - image: nginx name: mynginx [root@master ~] [root@master ~] [root@master ~] /docker-entrypoint.sh: /docker-entrypoint.d/ is not empty, will attempt to perform configuration /docker-entrypoint.sh: Looking for shell scripts in /docker-entrypoint.d/ /docker-entrypoint.sh: Launching /docker-entrypoint.d/10-listen-on-ipv6-by-default.sh 10-listen-on-ipv6-by-default.sh: info: Getting the checksum of /etc/nginx/conf.d/default.conf 10-listen-on-ipv6-by-default.sh: info: Enabled listen on IPv6 in /etc/nginx/conf.d/default.conf /docker-entrypoint.sh: Launching /docker-entrypoint.d/20-envsubst-on-templates.sh /docker-entrypoint.sh: Launching /docker-entrypoint.d/30-tune-worker-processes.sh /docker-entrypoint.sh: Configuration complete; ready for start up 2023/04/10 07:09:42 [notice] 1 2023/04/10 07:09:42 [notice] 1 2023/04/10 07:09:42 [notice] 1 2023/04/10 07:09:42 [notice] 1 2023/04/10 07:09:42 [notice] 1 2023/04/10 07:09:42 [notice] 1 2023/04/10 07:09:42 [notice] 1 2023/04/10 07:09:42 [notice] 1 [root@master ~] NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES mynginx 1/1 Running 0 3m55s 192.168.104.4 node2 <none> <none> [root@master ~] [root@master ~] [root@master1 ~] 集群中的任意一个机器,任意一个应用都能通过pod分配的ip访问pod NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES busybox 1/1 Terminating 0 127m 10.244.166.130 node1 <none> <none> 10.244网段只能在集群内访问

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 apiVersion: v1 kind: Pod metadata: labels: run: myapp name: myapp spec: containers: - image: nginx name: nginx - image: tomcat:8.5.68 name: tomcat pod内只需要通过127.0.0.1即可访问 pod内两个容器占用同一个端口会导致error

# labels标签其实就一对 key/value ,被关联到对象上,比如 Pod, 标签的使用我们倾向于能够表示对象的特殊特点,就是一眼就看出了这个 Pod 是干什么的,标签可以用来划分特定的对象(比如版本,服务类型等),标签可以在创建一个对象的时候直接定义,也可以在后期随时修改,每一个对象可以拥有多个标签,但是,key 值必须是唯一的。创建标签之后也可以方便我们对资源进行分组管理。如果对 pod 打标签,之后就可以使用标签来查看、删除指定的 pod。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 [root@master1 ~] [root@master1 ~] NAME READY STATUS RESTARTS AGE LABELS tomcat-cattt 1/1 Running 0 69m app=tomcat [root@master1 ~] pod/tomcat-cattt labeled [root@master1 ~] NAME READY STATUS RESTARTS AGE LABELS tomcat-cattt 1/1 Running 0 70m app=tomcat,hahaha=shabi [root@master1 ~] NAME READY STATUS RESTARTS AGE LABELS tomcat-cattt 1/1 Running 0 72m app=tomcat,hahaha=shabi [root@master1 ~] NAME READY STATUS RESTARTS AGE tomcat-cattt 1/1 Running 0 72m [root@master1 ~] NAME READY STATUS RESTARTS AGE LABELS tomcat-cattt 1/1 Running 0 73m app=tomcat,hahaha=shabi [root@master1 ~] NAME READY STATUS RESTARTS AGE HAHAHA tomcat-cattt 1/1 Running 0 73m shabi [root@master1 ~] NAME READY STATUS RESTARTS AGE HAHAHA APP tomcat-cattt 1/1 Running 0 74m shabi tomcat tomcat-test 1/1 Running 0 21h tomcat [root@master1 ~] NAMESPACE NAME READY STATUS RESTARTS AGE LABELS default busybox 1/1 Running 0 46h run=busybox default nginx-7f466444dc-8pbkp 1/1 Running 0 23h k8s-app=nginx,pod-template-hash=7f466444dc default nginx-7f466444dc-jbhpm 1/1 Running 0 23h k8s-app=nginx,pod-template-hash=7f466444dc default tomcat-cattt 1/1 Running 0 75m app=tomcat,hahaha=shabi default tomcat-test 1/1 Running 0 21h app=tomcat kube-system calico-kube-controllers-57c7b58f66-b7pw7 1/1 Running 0 46h k8s-app=calico-kube

# node 节点选择器我们在创建 pod 资源的时候,pod 会根据 schduler 进行调度,那么默认会调度到随机的一个工作节点,如果我们想要 pod 调度到指定节点或者调度到一些具有相同特点的 node 节点,

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 apiVersion: v1 kind: Pod metadata: name: demo-pod namespace: default labels: app: myapp env : dev spec: nodeName: master3 containers: - name: tomcat-pod-java ports: - containerPort: 8080 image: tomcat:9.0 imagePullPolicy: IfNotPresent - name: busybox image: busybox:latest imagePullPolicy: IfNotPresent command : - "/bin/sh" - "-c" - "sleep 3600" default demo-pod 2/2 Running 0 2m20s 10.244.136.2 master3 <none> <none>

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 apiVersion: v1 kind: Pod metadata: name: demo-pod-1 namespace: default labels: app: myapp env : dev spec: nodeSelector: disk: ceph containers: - name: tomcat-pod-java ports: - containerPort: 8080 image: tomcat:9.0 imagePullPolicy: IfNotPresent demo-pod-1 0/1 Pending 0 17s <none> <none> <none> <none> [root@master1 ~] NAME STATUS ROLES AGE VERSION LABELS master1 Ready control-plane,master 47h v1.20.6 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=master1,kubernetes.io/os=linux,node-role.kubernetes.io/control-plane=,node-role.kubernetes.io/master= master2 Ready control-plane,master 47h v1.20.6 beta.kubernetes.io/arch=amd64,beta.kubernetes.io/os=linux,kubernetes.io/arch=amd64,kubernetes.io/hostname=master2,kubernetes.io/os=linux,node-role.kubernetes.io/control-plane=,node-role.kubernetes.io/master= [root@master1 ~] apply -f 0/4 nodes are available: 1 node(s) didn't match Pod' s node affinity, 3 node(s) had taint {node-role.kubernetes.io/master: }, that the pod didn't tolerate. [root@master1 ~]# kubectl label nodes node1 disk=ceph [root@master1 ~]# kubectl apply -f demo-pod-1 1/1 Running 0 95s 10.244.166.139 node1 <none> <none> # 删除节点标签 [root@master1 ~]# kubectl label nodes master1 disk- node/master1 labeled # 只有nodename可以强行调度到master,nodeselector不能强行调度到master即使label匹配 # kubectl delete -f x.yaml --force --grace-period=0 强行删除pod

1 2 3 4 5 6 7 8 9 10 11 12 13 spec: nodeName: node2 nodeSelector: disk: ceph 总结:同一个yaml文件里定义pod资源,如果同时定义了nodeName和NodeSelector,那么条件必须都满足才可以,有一个不满足都会调度失败

# 节点亲和性、反亲和性node 节点亲和性调度:nodeAffinity

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 [root@master1 ~] KIND: Pod VERSION: v1 RESOURCE: affinity <Object> DESCRIPTION: If specified, the pod's scheduling constraints Affinity is a group of affinity scheduling rules. FIELDS: nodeAffinity <Object> Describes node affinity scheduling rules for the pod. podAffinity <Object> Describes pod affinity scheduling rules (e.g. co-locate this pod in the same node, zone, etc. as some other pod(s)). podAntiAffinity <Object> Describes pod anti-affinity scheduling rules (e.g. avoid putting this pod in the same node, zone, etc. as some other pod(s)). # node亲和性 [root@prometheus-master ~]# kubectl explain pods.spec.affinity.nodeAffinity KIND: Pod VERSION: v1 FIELDS: preferredDuringSchedulingIgnoredDuringExecution <[]Object> requiredDuringSchedulingIgnoredDuringExecution <Object> prefered表示有节点尽量满足这个位置定义的亲和性,这不是一个必须的条件,软亲和性 require表示必须有节点满足这个位置定义的亲和性,这是个硬性条件,硬亲和性 可以使用operator字段来为Kubernetes设置在解释规则时要使用的逻辑操作符。你可以使用In、NotIn, Exists , DoesNotExist,Gt和Lt之一作为操作符。 NotIn和 DoesNotExist可用来实现节点反亲和性行为。你也可以使用节点污点将Pod从特定节点上驱逐。 # 硬亲和性 vim pod6.yaml apiVersion: v1 kind: Pod metadata: name: pod-affinity namespace: default labels: app: myapp spec: containers: - name: pod-affinity image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent affinity: nodeAffinity: requiredDuringSchedulingIgnoredDuringExecution: nodeSelectorTerms: - matchExpressions: - key: zone # label key operator: In # condition values: # label value - foo - bar 由于初始没有node有zone这个label,所以会pending,一定有某个node被label对应的标签,pod会被立刻创建 pod-affinity 0/1 Pending 0 78s <none> prometheus-node2 pod-affinity 0/1 ContainerCreating 0 78s <none> prometheus-node2 pod-affinity 0/1 ContainerCreating 0 79s <none> prometheus-node2 pod-affinity 1/1 Running 0 80s 10.244.64.44 prometheus-node2 由于是硬亲和性,因此如果没有node有对应的label就不调度 [root@master1 ~]# kubectl apply -f pod6.yaml 0/4 nodes are available: 1 node(s) didn' t match Pod's node affinity, 3 node(s) had taint {node-role.kubernetes.io/master: }, that the pod didn' t tolerate.vim pod7.yaml apiVersion: v1 kind: Pod metadata: name: pod-node-affinity-demo-2 namespace: default labels: app: myapp tier: frontend spec: containers: - name: myapp image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent affinity: nodeAffinity: preferredDuringSchedulingIgnoredDuringExecution: - preference: matchExpressions: - key: zone1 operator: In values: - foo1 - bar1 weight: 10 - preference: matchExpressions: - key: zone2 operator: In values: - foo2 - bar2 weight: 20 [root@master1 ~] NAME READY STATUS RESTARTS AGE pod-node-affinity-demo-2 1/1 Running 0 5s [root@master1 ~] [root@master1 ~] [root@master1 ~] [root@master1 ~] [root@master1 ~]

pod 节点亲和性

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 pod自身的亲和性调度有两种表示形式: podaffinity:pod和pod更倾向在一起,把相近的pod结合到相近的位置,如同一区域,同一机架,这样的话pod和pod之间更好通信,比方说有两个机房,这两个机房部署的集群有1000台主机,那么我们希望把nginx和tomcat都部署同一个地方的node节点上,可以提高通信效率; podunaffinity:pod和pod更倾向不j在一起,如果部署两套程序,那么这两套程序更倾向于反亲和性,这样相互之间不会有影响。 prefer:软亲和性 required:硬亲和性 topologyKey:判断pod是否在同一位置 位置拓扑的键,这个是必须字段 怎么判断是不是同一个位置: rack=rack1 row=row1 使用rack的键是同一个位置 使用row的键是同一个位置 labelSelector: 我们要判断pod跟别的pod亲和,跟哪个pod亲和,需要靠labelSelector,通过labelSelector选则一组能作为亲和对象的pod资源 namespace: labelSelector需要选则一组资源,那么这组资源是在哪个名称空间中呢,通过namespace指定,如果不指定namespaces,那么就是当前创建pod的名称空间 vim pod8.yaml apiVersion: v1 kind: Pod metadata: name: pod-first labels: app2: myapp2 tier: frontend spec: containers: - name: myapp image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent vim pod9.yaml apiVersion: v1 kind: Pod metadata: name: pod-second labels: app: backend tier: db spec: containers: - name: busybox image: busybox:latest imagePullPolicy: IfNotPresent command: ["sh" ,"-c" ,"sleep 3600" ] affinity: podAffinity: requiredDuringSchedulingIgnoredDuringExecution: - labelSelector: matchExpressions: - {key: app2 , operator: In , values: ["myapp2" ]} topologyKey: kubernetes.io/hostname pod-first 1 /1 Running 0 19m 10.244 .166 .145 node1 <none> <none> pod-second 1 /1 Running 0 101s 10.244 .166 .146 node1 <none> <none> 先判断标签是否一样,来决定pod是否调度到一起,在根据topologyKey决定调度到那个node apiVersion: v1 kind: Pod metadata: name: pod-second labels: app: backend tier: db spec: containers: - name: busybox image: busybox:latest imagePullPolicy: IfNotPresent command: ["sh" ,"-c" ,"sleep 3600" ] affinity: podAffinity: preferredDuringSchedulingIgnoredDuringExecution: - weight: 10 podAffinityTerm: topologyKey: kubernetes.io/hostname labelSelector: matchExpressions: - {key: app1 , operator: In , values: ["myapp1" ]}

pod 反亲和性

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 vim pod10.yaml apiVersion: v1 kind: Pod metadata: name: pod-first labels: app1: myapp1 tier: frontend spec: containers: - name: myapp image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent [root@master1 ~ ] NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES pod-first 1 /1 Running 0 28s 10.244 .166 .147 node1 <none> <none> vim pod11.yaml apiVersion: v1 kind: Pod metadata: name: pod-second labels: app: backend tier: db spec: containers: - name: busybox image: busybox:latest imagePullPolicy: IfNotPresent command: ["sh" ,"-c" ,"sleep 3600" ] affinity: podAntiAffinity: requiredDuringSchedulingIgnoredDuringExecution: - labelSelector: matchExpressions: - {key: app1 , operator: In , values: ["myapp1" ]} topologyKey: kubernetes.io/hostname pod-first 1 /1 Running 0 4m26s 10.244 .166 .147 node1 <none> <none> pod-second 0 /1 Pending 0 25s <none> <none> <none> <none> pod-first 1 /1 Running 0 52s 10.244 .216 .124 prometheus-node1 <none> <none> pod-second 1 /1 Running 0 10s 10.244 .64 .48 prometheus-node2 <none> <none> kubectl label node node1 zone=foo kubectl label node node2 zone=foo vim po12.yaml apiVersion: v1 kind: Pod metadata: name: pod-first labels: app3: myapp3 tier: frontend spec: containers: - name: myapp image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent vim pod13.yaml apiVersion: v1 kind: Pod metadata: name: pod-second labels: app: backend tier: db spec: containers: - name: busybox image: busybox:latest imagePullPolicy: IfNotPresent command: ["sh" ,"-c" ,"sleep 3600" ] affinity: podAntiAffinity: requiredDuringSchedulingIgnoredDuringExecution: - labelSelector: matchExpressions: - {key: app3 ,operator: In , values: ["myapp3" ]} topologyKey: zone pod-first 1 /1 Running 0 62s 10.244 .216 .125 prometheus-node1 <none> <none> pod-second 0 /1 Pending 0 5s <none> <none> <none> <none> apiVersion: v1 kind: Pod metadata: name: pod-second labels: app: backend tier: db spec: containers: - name: busybox image: busybox:latest imagePullPolicy: IfNotPresent command: ["sh" ,"-c" ,"sleep 3600" ] affinity: podAntiAffinity: preferredDuringSchedulingIgnoredDuringExecution: - weight: 10 podAffinityTerm: topologyKey: zone labelSelector: matchExpressions: - {key: app3 , operator: In , values: ["myapp3" ]} pod-first 1 /1 Running 0 6m43s 10.244 .216 .125 prometheus-node1 <none> <none> pod-second 1 /1 Running 0 21s 10.244 .216 .126 prometheus-node1 <none> <none>

podaffinity:pod 节点亲和性,pod 倾向于哪个 pod podantiaffinity:pod 反亲和性 nodeaffinity:node 节点亲和性,pod 倾向于哪个 node

# 污点,容忍度给了节点选则的主动权,我们给节点打一个污点,不容忍的 pod 就运行不上来,污点就是定义在节点上的键值属性数据,可以定决定拒绝那些 pod;

tolerations 是键值数据,用在 pod 上,定义容忍度,能容忍哪些污点

pod 亲和性是 pod 属性;但是污点是 node 的属性,污点定义在 k8s 集群的节点上的一个字段

master 上会有污点Taints: node-role.kubernetes.io/master:NoSchedule

taints 的 effect 用来定义对 pod 对象的排斥等级(效果):

NoSchedule:

NoExecute:

PreferNoSchedule:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 [root@master1 ~] calico-node-mptp2 1/1 Running 1 5d4h 192.168.13.177 master1 <none> <none> coredns-7f89b7bc75-gtmmh 1/1 Running 1 5d4h 10.244.137.67 master1 <none> <none> coredns-7f89b7bc75-hc7ns 1/1 Running 1 5d4h 10.244.137.68 master1 <none> <none> etcd-master1 1/1 Running 3 5d4h 192.168.13.177 master1 <none> <none> kube-apiserver-master1 1/1 Running 5 5d4h 192.168.13.177 master1 <none> <none> kube-controller-manager-master1 1/1 Running 2 5d4h 192.168.13.177 master1 <none> <none> kube-proxy-t9td4 1/1 Running 1 5d4h 192.168.13.177 master1 <none> <none> kube-scheduler-master1 1/1 Running 2 5d4h 192.168.13.177 master1 <none> <none> [root@master1 ~] Tolerations: :NoExecute op=Exists [root@master1 ~] node/node1 tainted vim pod14.yaml apiVersion: v1 kind: Pod metadata: name: taint-pod namespace: default labels: tomcat: tomcat-pod spec: containers: - name: taint-pod ports: - containerPort: 8080 image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent taint-pod 1/1 Running 0 3s 10.244.216.127 prometheus-node1 <none> <none> 重新创建pod,pod无法忍受node1的污点 taint-pod 1/1 Running 0 4s 10.244.64.49 prometheus-node2 <none> <none> [root@master1 ~] default nginx-7f466444dc-klcl9 1/1 Terminating 0 4m32s 10.244.166.152 node1 <none> <none> vim pod15.yaml apiVersion: v1 kind: Pod metadata: name: myapp-deploy namespace: default labels: app: myapp release: canary spec: containers: - name: myapp image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent ports: - name: http containerPort: 8080 tolerations: - key: "node-type" operator: "Equal" value: "dev" effect: "NoExecute" tolerationSeconds: 3600 myapp-deploy 1/1 Running 0 2m27s 10.244.166.154 node1 <none> <none> [root@master1 ~] myapp-deploy 0/1 Pending 0 3s apiVersion: v1 kind: Pod metadata: name: myapp-deploy namespace: default labels: app: myapp release: canary spec: containers: - name: myapp image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent ports: - name: http containerPort: 8080 tolerations: - key: "node-type" operator: "Equal" value: "dev" effect: "NoSchedule" myapp-deploy 1/1 Running 0 28s 10.244.166.157 node1 <none> <none> tolerations: - key: "node-type" operator: "Exists" value: "" effect: "NoSchedule" tolerations: - key: "node-type" operator: "Exists" value: "" effect: "" myapp-deploy 1/1 Running 0 6s 10.244.166.158 node1 <none> <none>

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 当某种条件为真时,节点控制器会自动给节点添加一个污点。当前内置的污点包括: node.kubernetes.io/not-ready:节点未准备好。这相当于节点状况 Ready 的值为 "False"。 node.kubernetes.io/unreachable:节点控制器访问不到节点. 这相当于节点状况 Ready 的值为 "Unknown"。 node.kubernetes.io/memory-pressure:节点存在内存压力。 node.kubernetes.io/disk-pressure:节点存在磁盘压力。 node.kubernetes.io/pid-pressure: 节点的 PID 压力。 node.kubernetes.io/network-unavailable:节点网络不可用。 node.kubernetes.io/unschedulable: 节点不可调度。 node.cloudprovider.kubernetes.io/uninitialized:如果 kubelet 启动时指定了一个“外部”云平台驱动, 它将给当前节点添加一个污点将其标志为不可用。在 cloud-controller-manager 的一个控制器初始化这个节点后,kubelet 将删除这个污点。 在节点被驱逐时,节点控制器或者 kubelet 会添加带有 NoExecute 效果的相关污点。 如果异常状态恢复正常,kubelet 或节点控制器能够移除相关的污点。 在某些情况下,当节点不可达时,API 服务器无法与节点上的 kubelet 进行通信。 在与 API 服务器的通信被重新建立之前,删除 Pod 的决定无法传递到 kubelet。 同时,被调度进行删除的那些 Pod 可能会继续运行在分区后的节点上。 这些值都可以修改,比如在内存剩余不足指定数量后会自动打上node.kubernetes.io/disk-pressure的污点,且不能手工删除,除非空出指定大小的内存之后

# pod 常见状态和重启策略

第一阶段:Pending ):

2、我们在请求创建 pod 时,条件不满足,调度没有完成,没有任何一个节点能满足调度条件,已经创建了 pod 但是没有适合它运行的节点叫做挂起,调度没有完成。

失败( Failed ):Pod 中的所有容器都已终止了,并且至少有一个容器是因为失败终止。也就是说,容器以非 0 状态退出或者被系统终止。

未知( Unknown ):未知状态,所谓 pod 是什么状态是 apiserver 和运行在 pod 节点的 kubelet 进行通信获取状态信息的,如果节点之上的 kubelet 本身出故障,那么 apiserver 就连不上 kubelet,得不到信息了,就会看 Unknown,通常是由于与 pod 所在的 node 节点通信错误。

Error 状态:Pod 启动过程中发生了错误

成功( Succeeded ):Pod 中的所有容器都被成功终止,即 pod 里所有的 containers 均已 terminated。

第二阶段:Unschedulable :Pod 不能被调度, scheduler 没有匹配到合适的 node 节点

PodScheduled :pod 正处于调度中,在 scheduler 刚开始调度的时候,还没有将 pod 分配到指定的 node,在筛选出合适的节点后就会更新 etcd 数据,将 pod 分配到指定的 node

Initialized :所有 pod 中的初始化容器已经完成了

ImagePullBackOff :Pod 所在的 node 节点下载镜像失败

Running :Pod 内部的容器已经被创建并且启动。

Ready

扩展:还有其他状态,如下:

Evicted 状态:出现这种情况,多见于系统内存或硬盘资源不足,可 df-h 查看 docker 存储所在目录的资源使用情况,如果百分比大于 85%,就要及时清理下资源,尤其是一些大文件、docker 镜像。

CrashLoopBackOff:容器曾经启动了,但可能又异常退出了

查看内存,CPU,磁盘:

free -mh

top

df -hl

kubectl describe pod_name

kubectl logs pod_name

Pod 重启策略

Pod 的重启策略(RestartPolicy)应用于 Pod 内的所有容器,当某个容器异常退出或者健康检查失败时,kubelet 将根据 重启策略来进行相应的操作。

Pod 的 spec 中包含一个 restartPolicy 字段,其可能取值包括 Always、OnFailure 和 Never。默认值是 Always。

Always:只要容器异常退出,kubelet 就会自动重启该容器。(这个是默认的重启策略)

OnFailure:当容器终止运行且退出码不为 0 时,由 kubelet 自动重启该容器。

Never:不论容器运行状态如何,kubelet 都不会重启该容器。

(重启的不是 pod,是 pod 中的容器)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 apiVersion: v1 kind: Pod metadata: name: demo-pod namespace: default labels: app: myapp spec: restartPolicy: Always containers: - name: tomcat-pod-java ports: - containerPort: 8080 image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent

1 2 3 4 5 6 7 8 9 10 kubectl exec -it demo-pod -- /bin/bash /usr/local/tomcat/bin/shutdown.sh # always - complete - 重启 # onFailure - complete - 不会重启 # never - complete状态,不会重启 kill 1 # always error - 立刻重启 # onFailure - error - 重启 # never - error - 不重启

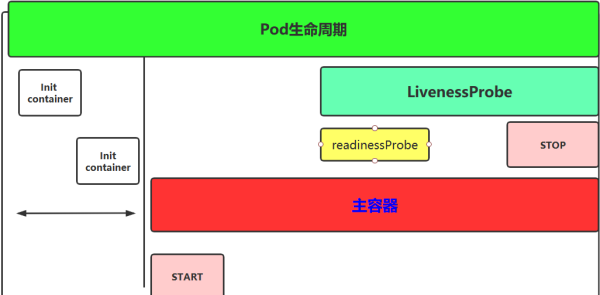

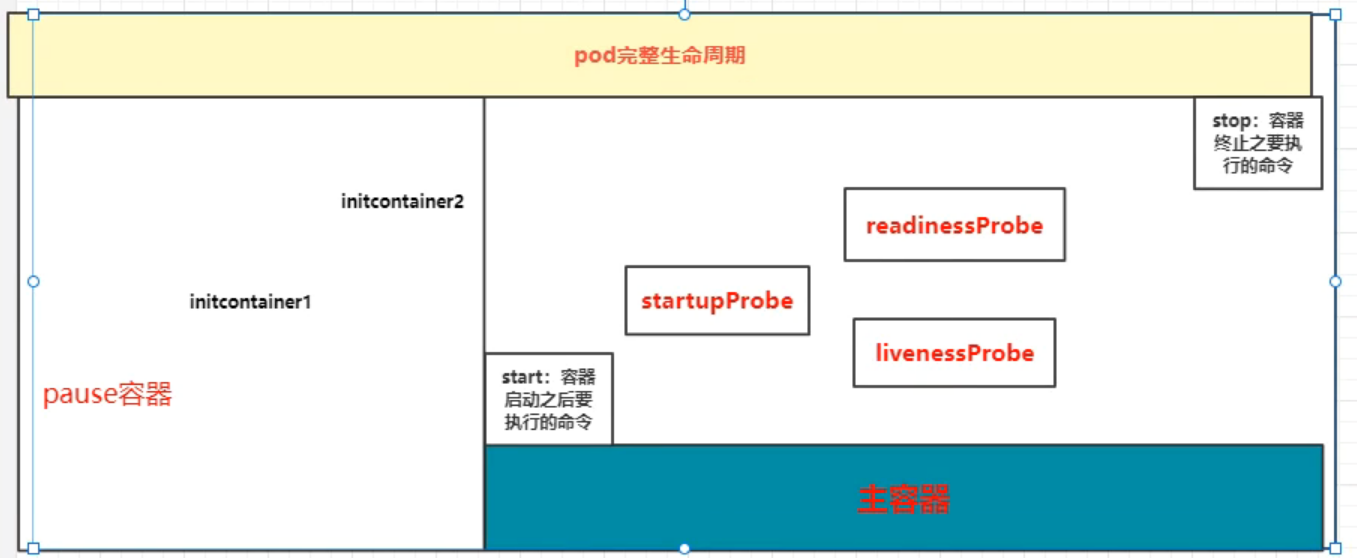

# pod 生命周期pod 从开始创建到终止退出的时间范围称为 Pod 生命周期

生命周期包含以下几个重要流程:

其中 initcontainers、容器启动后钩子、探测、容器终止前钩子这些是可选项 -

pod 在整个生命周期的过程中总会处于以下几个状态:

Pending:创建了 pod 资源并存入 etcd 中,但尚未完成调度。

ContainerCreating:Pod 的调度完成,被分配到指定 Node 上。处于容器创建的过程中。通常是在拉取镜像的过程中。

Running:Pod 包含的所有容器都已经成功创建,并且成功运行起来。

Succeeded:Pod 中的所有容器都已经成功终止并且不会被重启(重启策略是 never)

Failed:所有容器都已经终止,但至少有一个容器终止失败,也就是说容器返回了非 0 值的退出状态或已经被系统终止。

Unknown:因为某些原因无法取得 Pod 的状态。这种情况通常是因为与 Pod 所在主机通信失败。

pod 生命周期的重要行为:

1、在启动任何容器之前,先创建 pause 基础容器,它初始化 Pod 的环境并为后续加⼊的容器提供共享的名称空间。

2. 初始化容器(initcontainer):

一个 pod 可以拥有任意数量的 init 容器。init 容器是按照顺序以此执行的,并且仅当最后一个 init 容器执行完毕才会去启动主容器。

3. 生命周期钩子:

pod 允许定义两种类型的生命周期钩子,启动后 (post-start) 钩子和停止前 (pre-stop) 钩子

这些生命周期钩子是基于每个容器来指定的,和 init 容器不同的是,init 容器是应用到整个 pod。而这些钩子是针对容器的,是在容器启动后和停止前执行的。比如启动时复制文件到容器中,结束后发送信息到监控

4. 容器探测:

对 Pod 健康状态诊断。分为三种: Startupprobe、Livenessprobe (存活性探测), Readinessprobe (就绪性检测)

Startup(启动探测): 探测容器是否正常运行

Liveness (存活性探测):判断容器是否处于 runnning 状态,根据重启策略决定是否重启容器

Readiness (就绪性检测):判断容器是否准备就绪并对外提供服务,将容器设置为不可用,不接受 service 转发的请求

三种探针用于 Pod 检测:

ExecAction:在容器中执行一个命令,并根据返回的状态码进行诊断,只有返回 0 为成功

TCPSocketAction:通过与容器的某 TCP 端口尝试建立连接

HTTPGetAction:通过向容器 IP 地址的某指定端口的 path 发起 HTTP GET 请求。

6.pod 的终止过程

终止过程主要分为如下几个步骤:

(1) 用户发出删除 pod 命令:kubectl delete pods ,kubectl delete -f yaml

(2) Pod 对象随着时间的推移更新,在宽限期(默认情况下 30 秒),pod 被视为 “dead” 状态

(3) 将 pod 标记为 “Terminating” 状态

(4) 第三步同时运行,监控到 pod 对象为 “Terminating” 状态的同时启动 pod 关闭过程

(5) 第三步同时进行,endpoints 控制器监控到 pod 对象关闭,将 pod 与 service 匹配的 endpoints 列表中删除

(6) 如果 pod 中定义了 preStop 钩子处理程序,则 pod 被标记为 “Terminating” 状态时以同步的方式启动执行;若宽限期结束后,preStop 仍未执行结束,第二步会重新执行并额外获得一个 2 秒的小宽限期

(7) Pod 内对象的容器收到 TERM 信号

(8) 宽限期结束之后,若存在任何一个运行的进程,pod 会收到 SIGKILL 信号

(9) Kubelet 请求 API Server 将此 Pod 资源宽限期设置为 0 从而完成删除操作

# initcontainerspec 字段下有个 initContainers 字段 (初始化容器),Init 容器就是做初始化工作的容器。可以有一个或多个,如果多个按照定义的顺序依次执行,先执行初始化容器 1,再执行初始化容器 2 等,等初始化容器执行完具体操作之后初始化容器就退出了,只有所有的初始化容器执行完后,主容器才启动。

由于一个 Pod 里容器存储卷是共享的,所以 Init Container 里产生的数据可以被主容器使用到,Init Container 可以在多种 K8S 资源里被使用到,如 Deployment、DaemonSet, StatefulSet、Job 等,但都是在 Pod 启动时,在主容器启动前执行,做初始化工作。

初始化容器与主容器区别是:

初始化容器的官方地址:https://kubernetes.io/docs/concepts/workloads/pods/init-containers/#init-containers-in-use

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 apiVersion: v1 kind: Pod metadata: name: myapp-pod labels: app: myapp spec: initContainers: - name: init-myservice image: busybox:1.28 imagePullPolicy: IfNotPresent command : ['sh' , '-c' , "until nslookup myservice.$(cat /var/run/secrets/kubernetes.io/serviceaccount/namespace) .svc.cluster.local; do echo waiting for myservice; sleep 2; done" ] - name: init-mydb image: busybox:1.28 imagePullPolicy: IfNotPresent command : ['sh' , '-c' , "until nslookup mydb.$(cat /var/run/secrets/kubernetes.io/serviceaccount/namespace) .svc.cluster.local; do echo waiting for mydb; sleep 2; done" ] containers: - name: myapp-container image: busybox:1.28 command : ['sh' , '-c' , 'echo The app is running! && sleep 3600' ] myapp-pod 0/1 Init:0/2 0 4s 由于两个初始化容器一直无法解析nslookup的域名,导致主容器一致不会创建

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 apiVersion: v1 kind: Pod metadata: name: initnginx spec: initContainers: - name: install image: docker.io/library/busybox:1.28 imagePullPolicy: IfNotPresent command : - wget - "-O" - "/work-dir/index.html" - "https://www.baidu.com" volumeMounts: - name: workdir mountPath: /work-dir containers: - name: nginx image: nginx imagePullPolicy: IfNotPresent ports: - containerPort: 80 volumeMounts: - name: workdir mountPath: /usr/share/nginx/html dnsPolicy: Default volumes: - name: workdir emptyDir: {} [root@master1 ~] <!DOCTYPE html> <!--STATUS OK--><html> <head ><meta http-equiv=content-type content=text/html;charset=utf-8><meta http-equiv=X-UA-Compatible content=IE=Edge><meta content=always name=referrer><link rel=stylesheet type =text/css href=https://ss1.bdstatic.com/5eN1bjq8AAUYm2zgoY3K/r/www/cache/bdorz/baidu.min.css><title>百度一下,你就知道</title>

# 主容器1、容器钩子

初始化容器启动之后,开始启动主容器,在主容器启动之后有一个 post start hook(容器启动后钩子)和 pre stop hook(容器结束前钩子),无论启动后还是结束前所做的事我们可以把它放两个钩子,这个钩子就表示用户可以用它来钩住一些命令,非必须选项

postStart:该钩子在容器被创建后立刻执行,如果该钩子对应的探测执行失败,则该容器会被杀死,并根据该容器的重启策略决定是否要重启该容器,这个钩子不需要传递任何参数。

preStop:该钩子在容器被删除前执行,主要用于释放资源和优雅关闭程序

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 containers: - image: sample:v2 name: war lifecycle: postStart: exec: command: - "cp" - "/sample.war" - "/app" prestop: httpGet: host: monitor.com path: /waring port: 8080 scheme: HTTP

以上示例中,定义了一个 Pod,包含一个 JAVA 的 web 应用容器,其中设置了 PostStart 和 PreStop 回调函数。即在容器创建成功后,复制 /sample.war 到 /app 文件夹中。而在容器终止之前,发送 HTTP 请求到 http://monitor.com:8080/waring,即向监控系统发送警告。

优雅的删除资源对象

当用户请求删除含有 pod 的资源对象时(如 RC、deployment 等),K8S 为了让应用程序优雅关闭(即让应用程序完成正在处理的请求后,再关闭软件),K8S 提供两种信息通知:

1)、默认:K8S 通知 node 执行 docker stop 命令,docker 会先向容器中 PID 为 1 的进程发送系统信号 SIGTERM,然后等待容器中的应用程序终止执行,如果等待时间达到设定的超时时间,或者默认超时时间(30s),会继续发送 SIGKILL 的系统信号强行 kill 掉进程。

2)、使用 pod 生命周期(利用 PreStop 回调函数),它执行在发送终止信号之前。

1 2 3 4 5 6 7 8 9 10 11 12 13 spec: containers: - name: nginx-demo image: centos:nginx lifecycle: preStop: exec: command: ["/usr/local/nginx/sbin/nginx" ,"-s" ,"quit" ] ports: - name: http containerPort: 80

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 apiVersion: v1 kind: Pod metadata: name: life-demo spec: containers: - name: lifecycle-demo-container image: nginx imagePullPolicy: IfNotPresent lifecycle: postStart: exec: command: ["/bin/sh" , "-c" ,"echo 'lifecycle hookshandler' > /usr/share/nginx/html/test.html" ] preStop: exec: command: - "/bin/sh" - "-c" - "nginx -s stop" [root@prometheus-master pod ] root@life-demo:/# ls /usr/share/nginx/html/ 50x.html index.html test.html root@life-demo:/# cat /usr/share/nginx/html/test.html lifecycle hookshandler kubectl get event 0s Normal Killing pod/life-demo Stopping container lifecycle-demo-container 0s Normal Killing pod/life-demo Stopping container lifecycle-demo-container

pod 在整个生命周期中有非常多的用户行为:

1、初始化容器完成初始化

2、主容器启动后可以做启动后钩子

3、主容器结束前可以做结束前钩子

4、在主容器运行中可以做一些健康检测,如 startupprobe、livenessprobe,readnessprobe

# 容器探测在 Kubernetes 中 Pod 是最小的计算单元,而一个 Pod 又由多个容器组成,相当于每个容器就是一个应用,应用在运行期间,可能因为某些意外情况致使程序挂掉。那么如何监控这些容器状态稳定性,保证服务在运行期间不会发生问题,发生问题后进行重启等机制,就成为了重中之重的事情,考虑到这点 kubernetes 推出了活性探针机制。有了存活性探针能保证程序在运行中如果挂掉能够自动重启,但是还有个经常遇到的问题,比如说,在 Kubernetes 中启动 Pod,显示明明 Pod 已经启动成功,且能访问里面的端口,但是却返回错误信息。还有就是在执行滚动更新时候,总会出现一段时间,Pod 对外提供网络访问,但是访问却发生 404,这两个原因,都是因为 Pod 已经成功启动,但是 Pod 的的容器中应用程序还在启动中导致,考虑到这点 Kubernetes 推出了就绪性探针机制。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 apiVersion: v1 kind: Pod metadata: name: check namespace: default labels: app: check spec: containers: - name: check image: busybox:1.28 imagePullPolicy: IfNotPresent command: - /bin/sh - -c - sleep 10 ;exit

k8s 提供了三种来实现容器探测的方法,分别是:

1、startupProbe:探测容器中的应用是否已经启动。如果提供了启动探测 (startup probe),则暂时禁用所有其他探测,直到它成功为止。如果启动探测失败,kubelet 将杀死容器,容器服从其重启策略进行重启。如果容器没有提供启动探测,则默认状态为成功 Success。

2、livenessprobe:用指定的方式(exec、tcp、http)检测 pod 中的容器是否正常运行 ,如果检测失败,则认为容器不健康,那么 Kubelet 将根据 Pod 中设置的 restartPolicy 策略来判断 Pod 是否要进行重启操作,如果容器配置中没有配置 livenessProbe,Kubelet 将认为存活探针探测一直为 success(成功)状态。

3、readnessprobe:就绪性探针,用于检测容器中的应用是否可以接受请求 ,当探测成功后才使 Pod 对外提供网络访问,将容器标记为就绪状态,可以加到 pod 前端负载,如果探测失败,则将容器标记为未就绪状态,会把 pod 从前端负载移除。

可以自定义在 pod 启动时是否执行这些检测,如果不设置,则检测结果均默认为通过,如果设置,则顺序为 startupProbe>readinessProbe 和 livenessProbe,readinessProbe 和 livenessProbe 是并发关系

目前 LivenessProbe 和 ReadinessProbe、startupprobe 探测都支持下面三种探针:

1、exec:在容器中执行指定的命令,如果执行成功,退出码为 0 则探测成功。

2、TCPSocket:通过容器的 IP 地址和端口号执行 TCP 检 查,如果能够建立 TCP 连接,则表明容器健康。

3、HTTPGet:通过容器的 IP 地址、端口号及路径调用 HTTP Get 方法,如果响应的状态码大于等于 200 且小于 400,则认为容器健康

探针探测结果有以下值:

1、Success:表示通过检测。

2、Failure:表示未通过检测。

3、Unknown:表示检测没有正常进行。

Pod 探针相关的属性:

探针 (Probe) 有许多可选字段,可以用来更加精确的控制 Liveness 和 Readiness 两种探针的行为

initialDelaySeconds:容器启动后要等待多少秒后探针开始工作,单位 “秒”,默认是 0 秒,最小值是 0

periodSeconds: 执行探测的时间间隔(单位是秒),默认为 10s,单位 “秒”,最小值是 1

timeoutSeconds: 探针执行检测请求后,等待响应的超时时间,默认为 1,单位 “秒”。

successThreshold:连续探测几次成功,才认为探测成功,默认为 1,在 Liveness 探针中必须为 1,最小值为 1。

failureThreshold: 探测失败的重试次数,重试一定次数后将认为失败,在 readiness 探针中,Pod 会被标记为未就绪,默认为 3,最小值为 1

两种探针区别:

ReadinessProbe 和 livenessProbe 可以使用相同探测方式,只是对 Pod 的处置方式不同:

readinessProbe 当检测失败后,将 Pod 的 IP:Port 从对应的 EndPoint 列表中删除。

livenessProbe 当检测失败后,将杀死容器并根据 Pod 的重启策略来决定作出对应的措施。

# 启动探测1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 apiVersion: v1 kind: Pod metadata: name: startupprobe spec: containers: - name: startup image: tomcat-8.5-jre8 imagePullPolicy: IfNotPresent ports: - containerPort: 8080 startupProbe: exec: command: - "/bin/sh" - "-c" - "ps aux | grep tomcat" initialDelaySeconds: 20 periodSeconds: 20 timeoutSeconds: 10 successThreshold: 1 failureThreshold: 3 initialDelaySeconds + (periodSeconds + timeoutSeconds) * failureThreshold

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 apiVersion: v1 kind: Pod metadata: name: startupprobe spec: containers: - name: startup image: tomcat:9.0 imagePullPolicy: IfNotPresent ports: - containerPort: 8080 startupProbe: tcpSocket: port: 8080 initialDelaySeconds: 20 periodSeconds: 20 timeoutSeconds: 10 successThreshold: 1 failureThreshold: 3 startupprobe 0 /1 ContainerCreating 0 0s <none> node1 <none> <none> startupprobe 0 /1 ContainerCreating 0 1s <none> node1 <none> <none> startupprobe 0 /1 Running 0 2s 10.244 .166 .168 node1 <none> <none> startupprobe 0 /1 Running 0 36s 10.244 .166 .168 node1 <none> <none> startupprobe 1 /1 Running 0 78s 10.244 .166 .168 node1 <none> <none>

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 apiVersion: v1 kind: Pod metadata: name: startupprobe spec: containers: - name: startup image: tomcat:9.0 imagePullPolicy: IfNotPresent ports: - containerPort: 8080 startupProbe: httpGet: path: / port: 8080 initialDelaySeconds: 20 periodSeconds: 20 timeoutSeconds: 10 successThreshold: 1 failureThreshold: 3

# 存活探测1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 apiVersion: v1 kind: Pod metadata: name: liveness-exec labels: app: liveness spec: containers: - name: liveness image: busybox:1.28 imagePullPolicy: IfNotPresent args: - /bin/sh - -c - touch /tmp/healthy; sleep 30; rm -rf /tmp/healthy; sleep 600 livenessProbe: initialDelaySeconds: 10 periodSeconds: 5 exec : command : - cat - /tmp/healthy liveness-exec 1/1 Running 0 2s 10.244.166.171 node1 <none> <none> liveness-exec 1/1 Running 1 76s 10.244.166.171 node1 <none> <none> liveness-exec 1/1 Running 2 2m30s 10.244.166.171 node1 <none> <none> 10 + 20 * 3

容器启动设置执行的命令:

/bin/sh -c “touch /tmp/healthy; sleep 30; rm -rf /tmp/healthy; sleep 600”

容器在初始化后,首先创建一个 /tmp/healthy 文件,然后执行睡眠命令,睡眠 30 秒,到时间后执行删除 /tmp/healthy 文件命令。而设置的存活探针检检测方式为执行 shell 命令,用 cat 命令输出 healthy 文件的内容,如果能成功执行这条命令,存活探针就认为探测成功,否则探测失败。在前 30 秒内,由于文件存在,所以存活探针探测时执行 cat /tmp/healthy 命令成功执行。30 秒后 healthy 文件被删除,所以执行命令失败,Kubernetes 会根据 Pod 设置的重启策略来判断,是否重启 Pod。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 apiVersion: v1 kind: Pod metadata: name: liveness-http labels: test: liveness spec: containers: - name: liveness image: mydlqclub/springboot-helloworld:0.0.1 imagePullPolicy: IfNotPresent livenessProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 8081 path: /actuator/health

上面 Pod 中启动的容器是一个 SpringBoot 应用,其中引用了 Actuator 组件,提供了 /actuator/health 健康检查地址,存活探针可以使用 HTTPGet 方式向服务发起请求,请求 8081 端口的 /actuator/health 路径来进行存活判断:

任何大于或等于 200 且小于 400 的代码表示探测成功。

任何其他代码表示失败。

如果探测失败,则会杀死 Pod 进行重启操作。

httpGet 探测方式有如下可选的控制字段:

scheme: 用于连接 host 的协议,默认为 HTTP。

host:要连接的主机名,默认为 Pod IP,可以在 http request head 中设置 host 头部。

port:容器上要访问端口号或名称。

path:http 服务器上的访问 URI。

httpHeaders:自定义 HTTP 请求 headers,HTTP 允许重复 headers。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 apiVersion: v1 kind: Pod metadata: name: liveness-tcp labels: app: liveness spec: containers: - name: liveness image: nginx imagePullPolicy: IfNotPresent livenessProbe: initialDelaySeconds: 15 periodSeconds: 20 tcpSocket: port: 80

# 就绪探测Pod 的 ReadinessProbe 探针使用方式和 LivenessProbe 探针探测方法一样,也是支持三种,只是一个是用于探测应用的存活,一个是判断是否对外提供流量的条件。这里用一个 Springboot 项目,设置 ReadinessProbe 探测 SpringBoot 项目的 8081 端口下的 /actuator/health 接口,如果探测成功则代表内部程序以及启动,就开放对外提供接口访问,否则内部应用没有成功启动,暂不对外提供访问,直到就绪探针探测成功。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 当检测失败后,将 Pod 的 IP:Port 从对应的 EndPoint 列表中删除。 检测成功后才会加到service的endpoint中 apiVersion: v1 kind: Service metadata: name: springboot labels: app: springboot spec: type : NodePort ports: - name: server port: 8080 targetPort: 8080 nodePort: 31180 - name: management port: 8081 targetPort: 8081 nodePort: 31181 selector: app: springboot --- apiVersion: v1 kind: Pod metadata: name: springboot labels: app: springboot spec: containers: - name: springboot image: mydlqclub/springboot-helloworld:0.0.1 imagePullPolicy: IfNotPresent ports: - name: server containerPort: 8080 - name: management containerPort: 8081 readinessProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 8081 path: /actuator/health

# 混合使用三种探测1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 apiVersion: v1 kind: Service metadata: name: springboot-live labels: app: springboot spec: type : NodePort ports: - name: server port: 8080 targetPort: 8080 nodePort: 31180 - name: management port: 8081 targetPort: 8081 nodePort: 31181 selector: app: springboot --- apiVersion: v1 kind: Pod metadata: name: springboot-live labels: app: springboot spec: containers: - name: springboot image: mydlqclub/springboot-helloworld:0.0.1 imagePullPolicy: IfNotPresent ports: - name: server containerPort: 8080 - name: management containerPort: 8081 readinessProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 8081 path: /actuator/health livenessProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 8081 path: /actuator/health startupProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 8081 path: /actuator/health

# ReplicasetPod 类型的自主式 pod,但是这存在一个问题,假如 pod 被删除了,那这个 pod 就不能自我恢复,就会彻底被删除,线上这种情况非常危险,pod 的控制器,所谓控制器就是能够管理 pod,监测 pod 运行状况,当 pod 发生故障,可以自动恢复 pod。也就是说能够代我们去管理 pod 中间层,并帮助我们确保每一个 pod 资源始终处于我们所定义或者我们所期望的目标状态,一旦 pod 资源出现故障,那么控制器会尝试重启 pod 或者里面的容器,如果一直重启有问题的话那么它可能会基于某种策略来进行重新布派或者重新编排;如果 pod 副本数量低于用户所定义的目标数量,它也会自动补全;如果多余,也会自动终止 pod 资源。

kubectl explain rs

ReplicaSet 是 kubernetes 中的一种副本控制器,简称 rs,主要作用是控制由其管理的 pod,使 pod 副本的数量始终维持在预设的个数。它的主要作用就是保证一定数量的 Pod 能够在集群中正常运行,它会持续监听这些 Pod 的运行状态,在 Pod 发生故障时重启 pod,pod 数量减少时重新运行新的 Pod 副本。官方推荐不要直接使用 ReplicaSet,用 Deployments 取而代之,Deployments 是比 ReplicaSet 更高级的概念,它会管理 ReplicaSet 并提供很多其它有用的特性,最重要的是 Deployments 支持声明式更新,声明式更新的好处是不会丢失历史变更。所以 Deployment 控制器不直接管理 Pod 对象,而是由 Deployment 管理 ReplicaSet,再由 ReplicaSet 负责管理 Pod 对象。

Replicaset 控制器主要由三个部分组成:

1、用户期望的 pod 副本数:用来定义由这个控制器管控的 pod 副本有几个

2、标签选择器:选定哪些 pod 是自己管理的,如果通过标签选择器选到的 pod 副本数量少于我们指定的数量,需要用到下面的组件

3、pod 资源模板:如果集群中现存的 pod 数量不够我们定义的副本中期望的数量怎么办,需要新建 pod,这就需要 pod 模板,新建的 pod 是基于模板来创建的。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 apiVersion: apps/v1 kind: ReplicaSet metadata: name: frontend labels: app: shabi tier: zhizhang spec: replicas: 3 selector: matchLabels: tier1: frontend1 template: metadata: labels: tier1: frontend1 spec: containers: - name: nginx image: nginx imagePullPolicy: IfNotPresent ports: - containerPort: 80 readinessProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 80 path: / startupProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 80 path: / livenessProbe: initialDelaySeconds: 20 periodSeconds: 5 timeoutSeconds: 10 httpGet: scheme: HTTP port: 80 path: / [root@prometheus-master replicaset ] NAME DESIRED CURRENT READY AGE frontend 3 3 3 8s pod名字 = repset名字 - 随机数,所以在template中只需要定义标签,不需要名字 删除pod之后,pod ip会变,会产生一个IP不同的新的pod repset永远让pod数量维持 [root@prometheus-master replicaset ] NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES frontend-8t7jx 1 /1 Running 0 56s 10.244 .216 .104 prometheus-node1 <none> <none> frontend-qx7dx 1 /1 Running 0 56s 10.244 .64 .21 prometheus-node2 <none> <none> frontend-s8jgx 1 /1 Running 0 56s 10.244 .216 .103 prometheus-node1 <none> <none>

# pod 动态扩缩容replicaset 可以实现动态变更副本数和镜像

变更镜像的时候需要手动删除原来的 pod (delete pods) 不会滚动更新,如果增加副本数只需要在原有基础上增加 pod 即可,删除副本是随机删除 pod

ReplicaSet 最核心的功能是可以动态扩容和回缩,如果我们觉得两个副本太少了,想要增加,只需要修改配置文件 replicaset.yaml 里的 replicas 的值即可,原来 replicas: 3,现在变成 replicaset: 4,修改之后,执行如下命令更新:

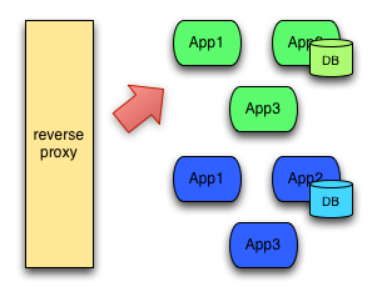

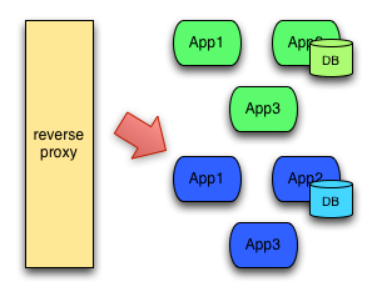

生产环境如果升级,可以删除一个 pod,观察一段时间之后没问题再删除另一个 pod,但是这样需要人工干预多次;实际生产环境一般采用蓝绿发布,原来有一个 rs1,再创建一个 rs2(控制器),通过修改 service 标签,修改 service 可以匹配到 rs2 的控制器,这样才是蓝绿发布,这个也需要我们精心的部署规划,我们有一个控制器就是建立在 rs 之上完成的,叫做 Deployment

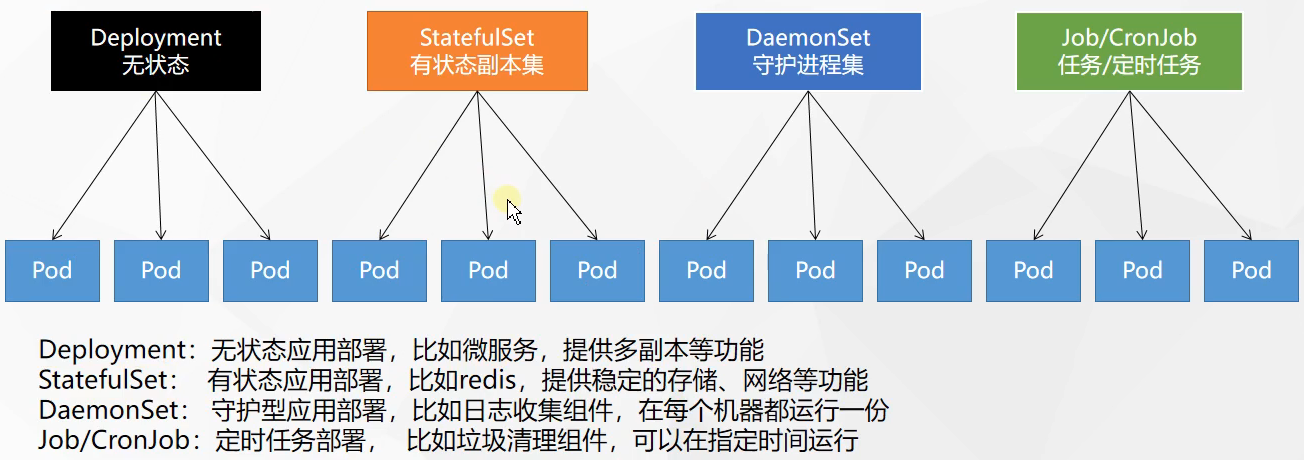

# deploymentDeployment 是 kubernetes 中最常用的资源对象,为 ReplicaSet 和 Pod 的创建提供了一种声明式的定义方法,在 Deployment 对象中描述一个期望的状态,Deployment 控制器就会按照一定的控制速率把实际状态改成期望状态,通过定义一个 Deployment 控制器会创建一个新的 ReplicaSet 控制器,通过 ReplicaSet 创建 pod,删除 Deployment 控制器,也会删除 Deployment 控制器下对应的 ReplicaSet 控制器和 pod 资源.

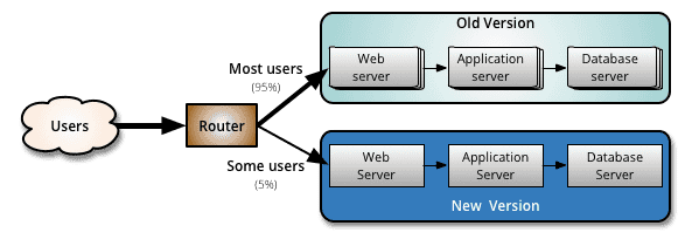

使用 Deployment 而不直接创建 ReplicaSet 是因为 Deployment 对象拥有许多 ReplicaSet 没有的特性,例如滚动升级、金丝雀发布、蓝绿部署和回滚。

声明式定义是指直接修改资源清单 yaml 文件,然后通过 kubectl apply -f 资源清单 yaml 文件,就可以更改资源

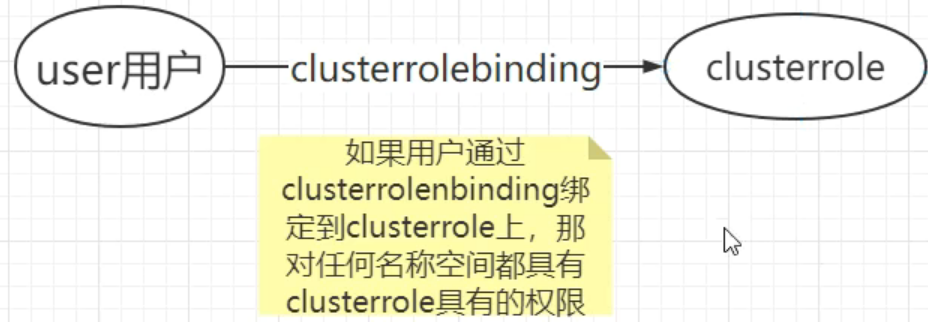

Deployment 控制器是建立在 rs 之上的一个控制器,可以管理多个 rs,每次更新镜像版本,都会生成一个新的 rs,把旧的 rs 替换掉,多个 rs 同时存在,但是只有一个 rs 运行。